Kategorien:

Cloud vs On Premise: Der Entscheidungsleitfaden für IT-Profis

Was Cloud vs. On-Premise wirklich für Ihr Unternehmen bedeutet

Die Debatte Cloud vs. On-Premise wird oft fälschlicherweise auf eine rein technische Ebene reduziert. Tatsächlich ist es eine der grundlegendsten strategischen Entscheidungen, die ein Unternehmen treffen kann. Erfahrene IT-Führungskräfte verstehen, dass es hier nicht nur um den physischen Standort von Servern geht, sondern um die grundlegende Ausrichtung des gesamten Betriebs. Diese Wahl hat direkten Einfluss auf Ihre geschäftliche Agilität, Ihr Risikomanagement und Ihre Fähigkeit, auf Marktveränderungen zu reagieren.

Viele Unternehmen, insbesondere im deutschen Mittelstand, überdenken ihre ursprüngliche Entscheidung im Nachhinein. Eine verbreitete Fehleinschätzung ist, Cloud Computing als reine Auslagerung von Hardware zu betrachten. Das ist eine riskante Vereinfachung. Eine Cloud-Infrastruktur verändert die gesamte IT-Governance. Anstatt sich auf die physische Wartung zu konzentrieren, muss Ihr Team Kompetenzen im Management von Cloud-Ressourcen, in der Kostenkontrolle und in der Sicherheitskonfiguration von Drittanbieter-Diensten entwickeln. Dies erfordert eine fundamentale Neuausrichtung von Fähigkeiten und Zuständigkeiten.

Im Gegensatz dazu wird On-Premise oft mit veralteter Technologie gleichgesetzt, was ebenso kurzsichtig ist. Eine eigene Infrastruktur bietet die ultimative Kontrolle über Daten, Abläufe und Sicherheitsprotokolle. Für Betriebe in stark regulierten Branchen oder mit sehr spezifischen Leistungsanforderungen kann dies ein entscheidender Vorteil sein. Die eigentliche Herausforderung liegt hier nicht in der Hardware, sondern in der Fähigkeit, diese Infrastruktur effizient, sicher und skalierbar zu betreiben. Dies bindet Kapital und erfordert hoch qualifiziertes Personal, das kontinuierlich weitergebildet werden muss.

Der strategische Kern der Entscheidung

Die richtige Wahl sollte sich an Ihrer Geschäftsstrategie orientieren, nicht an technologischen Trends. Berücksichtigen Sie die folgenden Punkte:

- Wachstumspläne: Ein schnell wachsendes Start-up mit unvorhersehbaren Lastspitzen profitiert stark von der Skalierbarkeit der Cloud. Ein etabliertes Unternehmen mit stabilen und vorhersehbaren Arbeitslasten kann mit einer optimierten On-Premise-Lösung kosteneffizienter arbeiten.

- Innovationsgeschwindigkeit: Firmen, die zügig neue digitale Produkte testen und einführen möchten, können die sofort verfügbaren Dienste der Cloud (z. B. KI-Modelle, Datenbanken) nutzen. On-Premise-Umgebungen benötigen für die Bereitstellung solcher Ressourcen längere Vorlaufzeiten.

- Risikotoleranz und Compliance: Ein Unternehmen, das sensible Daten verarbeitet und strengen Compliance-Vorgaben wie der DSGVO unterliegt, muss sorgfältig abwägen. On-Premise ermöglicht direkte Kontrolle, während Cloud-Anbieter spezialisierte Compliance-Zertifikate vorweisen können. Die Verantwortung bleibt jedoch immer beim Unternehmen. In unserem Leitfaden zu Cloud-Lösungen für Unternehmen gehen wir detaillierter auf diese Aspekte ein.

Die wirtschaftliche Realität hinter dem Hype

Die Diskussion um Cloud vs. On-Premise wird auch von einer starken Marktdynamik beeinflusst. In Deutschland wächst der Cloud-Markt sehr schnell, was die Verfügbarkeit von Diensten und den Wettbewerb steigert. Prognosen zufolge wird der Public-Cloud-Markt hierzulande bis 2025 einen Umsatz von 37,83 Milliarden US-Dollar erreichen, wobei Software-as-a-Service (SaaS) den größten Anteil hat. Diese Entwicklung zeigt, dass immer mehr Firmen auf abonnementbasierte Modelle umsteigen. Mehr Informationen zu dieser Entwicklung finden Sie in der Analyse zum deutschen Public-Cloud-Markt bei Statista.

Letztlich geht es darum, die Infrastruktur auszuwählen, die Ihre Geschäftsziele am besten unterstützt. Eine oberflächliche Kostenrechnung oder das blinde Folgen eines Trends führt fast immer zu teuren Nachbesserungen. Erfolgreiche Unternehmen analysieren ihre spezifischen Workloads, Sicherheitsanforderungen und Wachstumsstrategien, bevor sie eine endgültige Entscheidung treffen.

Die wahren Kosten entschlüsseln: Warum 80 % falsch rechnen

Die Kostenfrage ist im Duell Cloud vs. On-Premise oft der entscheidende Punkt – und zugleich die größte Fehlerquelle. Oberflächliche Vergleiche, die lediglich die Anschaffungskosten für Hardware mit den monatlichen Cloud-Gebühren verrechnen, führen in die Irre. Analysen von Total-Cost-of-Ownership-Modellen (TCO) bei deutschen Unternehmen zeigen ein klares Muster: Die tatsächlichen Ausgaben weichen oft drastisch von der ursprünglichen Kalkulation ab. Es wird geschätzt, dass ein mittelständisches Unternehmen im Schnitt 40 % mehr als geplant zahlt, unabhängig vom gewählten Modell.

Der Grund dafür sind die versteckten Kosten, die in Standardvergleichen systematisch übersehen werden. Cloud-Anbieter bewerben ihre flexiblen Pay-as-you-go-Modelle, verschweigen aber oft die teils erheblichen Gebühren für den Datenverkehr aus der Cloud heraus (Egress-Gebühren), für notwendige Compliance-Werkzeuge oder den Premium-Support, der bei kritischen Problemen unerlässlich ist. Umgekehrt unterschätzen Befürworter von On-Premise-Lösungen häufig die indirekten Ausgaben. Hierzu zählen nicht nur Strom und Kühlung, sondern auch Personalkosten für Spezialisten, Ausfallrisiken und die Opportunitätskosten durch langsame Skalierung.

Die wahre Kostenstruktur im Vergleich

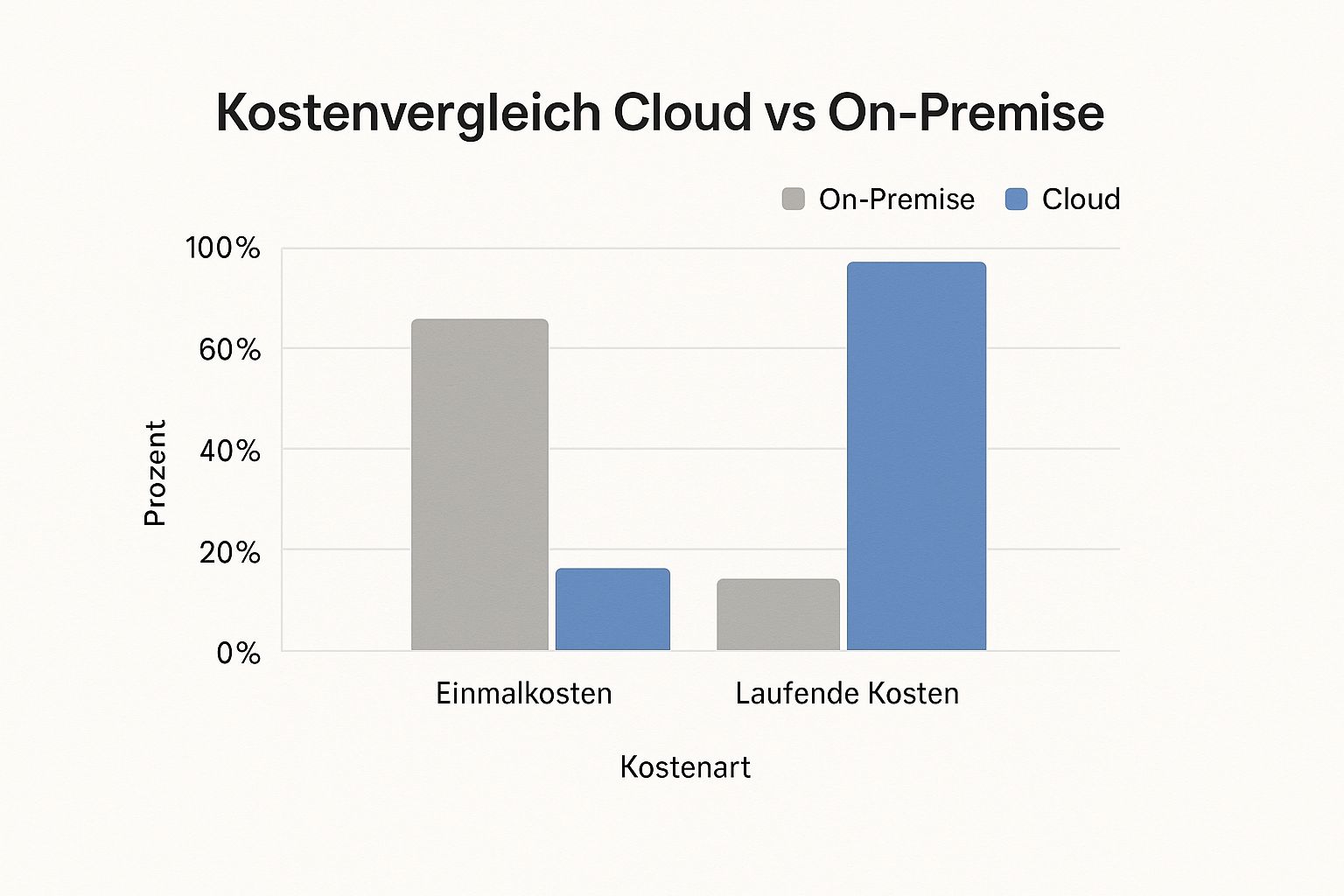

Die grundlegende Kostenstruktur der beiden Modelle ist fundamental verschieden, was häufig zu Fehlannahmen führt. On-Premise-Lösungen zeichnen sich durch hohe Anfangsinvestitionen (CapEx) und geringere laufende Kosten (OpEx) aus. Die Cloud kehrt dieses Prinzip um: Geringe oder keine Anfangsinvestitionen treffen auf hohe, variable Betriebskosten.

Dieses Balkendiagramm veranschaulicht die typische Verteilung von Einmal- und laufenden Kosten für beide Infrastrukturmodelle.

Die Grafik macht deutlich, dass der Großteil der On-Premise-Kosten bei der Anschaffung entsteht, während bei Cloud-Lösungen der laufende Betrieb den Löwenanteil ausmacht. Eine realistische Budgetierung muss deshalb weit über den Tag der Anschaffung hinausgehen.

Versteckte Kosten, die Budgets sprengen

Erfahrene CFOs wissen, dass eine echte TCO-Analyse viel tiefer graben muss. Um die wirklichen Kosten aufzudecken, ist ein Blick auf die Posten nötig, die Anbieter selten hervorheben und die in den meisten ersten Vergleichen fehlen.

Die folgende Tabelle basiert auf der Analyse von 200 deutschen Unternehmensbudgets und zeigt auf, wo die größten unvorhergesehenen Kosten lauern.

Versteckte Kosten: Was Anbieter nicht erwähnen Realistische TCO-Aufschlüsselung basierend auf 200 deutschen Unternehmensanalysen

| Kostenfaktor | Cloud (versteckt) | On-Premise (versteckt) | Typische Abweichung |

|---|---|---|---|

| Daten-Egress | Hohe Gebühren für ausgehenden Datenverkehr | Keine direkten Gebühren | +15-30% bei datenintensiven Anwendungen |

| Personalaufwand | Experten für FinOps, Cloud-Security, Architektur | Experten für Hardware, Netzwerk, Kühlung, physische Sicherheit | +/- 10% (Bedarfsverschiebung, keine Einsparung) |

| Software-Lizenzen | Komplexe, nutzungsbasierte Modelle, Anbieter-Audits | Einmalkosten mit Wartungsverträgen, aber starrer | +10-25% durch unklare Cloud-Lizenzbedingungen |

| Migration & Integration | Einmaliger hoher Aufwand für den Umzug | Geringer, da Systeme meist organisch wachsen | +50-100% über dem initialen Migrationsbudget |

| Compliance & Sicherheit | Zusätzliche Tools für Security-Monitoring notwendig | Physische Sicherheitsmaßnahmen (Zutritt, Brandschutz) | +20% für notwendige Zusatz-Tools |

| Ausfallkosten & SLAs | Indirekter Geschäftsschaden nicht durch SLA gedeckt | Volles finanzielles Risiko für Hardware-Ausfall | Schwer quantifizierbar, aber oft unterschätzt |

Die Tabelle macht deutlich, dass beide Modelle ihre eigenen Kostentreiber haben, die unter der Oberfläche liegen. Ein reiner Vergleich von Serverpreisen mit Monatsgebühren ist daher unzureichend.

Ein deutliches Warnsignal für explodierende Kosten ist ein Mangel an Transparenz und Kontrolle. Fehlt ein detailliertes Monitoring der Cloud-Nutzung oder eine genaue Erfassung der Arbeitsstunden für die Wartung eigener Server, ist eine Budgetüberschreitung fast unvermeidlich. Eine ehrliche Auseinandersetzung mit diesen versteckten Faktoren ist der erste Schritt zu einer soliden und nachhaltigen Infrastrukturentscheidung.

Sicherheit und Compliance: Schluss mit den Mythen

In der Diskussion um Cloud vs. On-Premise halten sich hartnäckig einige Mythen, besonders wenn es um Sicherheit geht. Oft wird angenommen, dass eine lokale Infrastruktur sicherer ist, nur weil die Hardware physisch im eigenen Haus steht. Die Realität sieht jedoch anders aus. Kontrolle über die Hardware bedeutet nicht automatisch höhere Sicherheit, sondern überträgt die volle Verantwortung auf das Unternehmen. Jeder Konfigurationsfehler, jede übersehene Sicherheitslücke und jede versäumte Wartung wird zum betriebsinternen Risiko.

Im Gegensatz dazu investieren große Cloud-Anbieter wie Amazon Web Services (AWS), Microsoft Azure oder Google Cloud enorme Summen in ihre Sicherheitsarchitektur und beschäftigen ganze Armeen von Spezialisten. Ihre Rechenzentren sind gegen physische und digitale Angriffe oft weitaus besser geschützt, als es sich die meisten Unternehmen leisten könnten. Analysen zeigen immer wieder, dass die Mehrheit der Sicherheitsvorfälle nicht auf Schwachstellen der Cloud-Plattformen selbst, sondern auf Fehlkonfigurationen durch die Nutzer zurückzuführen ist. Das größte Risiko liegt also nicht beim Anbieter, sondern im unsachgemäßen Umgang mit dessen leistungsstarken Diensten.

Die neue Risikokategorie: Fehlkonfiguration in der Cloud

Der Umzug in die Cloud verändert die Risikolandschaft. Während On-Premise-Systeme oft durch eine klare Abgrenzung nach außen (Perimeter-Sicherheit) geschützt werden, sind Cloud-Umgebungen von Grund auf offener und verteilter aufgebaut. Ein einziger Fehler in der Verwaltungskonsole kann ausreichen, um sensible Daten versehentlich für das gesamte Internet freizugeben.

Zu den typischen Fehlerquellen in der Cloud gehören:

- Ungesicherte Storage-Buckets: Öffentlich zugängliche Datenspeicher sind eine der häufigsten Ursachen für Datenlecks.

- Schwache Zugriffsberechtigungen (IAM): Werden Mitarbeitern zu weitreichende Rechte gewährt, potenziert dies das Risiko bei kompromittierten Benutzerkonten.

- Offene Netzwerkports: Nicht benötigte Ports, die ungesichert bleiben, dienen Angreifern als Einfallstore.

Diese Risiken machen deutlich, dass Cloud-Sicherheit einen Paradigmenwechsel erfordert. Der Fokus verschiebt sich von der Absicherung physischer Server hin zu einem strikten Management von Konfigurationen, Identitäten und Zugriffsrechten.

Compliance in der Praxis: DSGVO und Haftung

In Deutschland ist die Einhaltung der DSGVO ein entscheidender Faktor bei der Wahl zwischen Cloud und On-Premise. Entgegen einer verbreiteten Meinung ist keines der beiden Modelle automatisch konform oder nicht konform. Die Verantwortung für den Datenschutz bleibt immer beim Unternehmen, dem sogenannten „Controller“ der Daten.

Bei einer On-Premise-Lösung behalten Sie die vollständige Kontrolle über den Speicherort der Daten, was die Einhaltung der DSGVO auf den ersten Blick erleichtert. Gleichzeitig tragen Sie jedoch die alleinige Last für die Umsetzung aller technischen und organisatorischen Maßnahmen (TOMs). In der Cloud können Sie hingegen auf zertifizierte Anbieter bauen, die viele dieser Anforderungen bereits abdecken. Entscheidend sind hier die Auswahl des passenden Anbieters und die korrekte Konfiguration der genutzten Dienste. Detaillierte Informationen dazu bietet unser Beitrag zur Auswahl einer DSGVO-konformen Cloud-Lösung.

Die deutsche Wirtschaft nutzt Cloud-Dienste intensiv. Dabei dominieren Modelle wie SaaS, IaaS und PaaS den Markt, wobei Software-as-a-Service (SaaS) im Jahr 2024 einen Anteil von 67,92 % erreichte. Diese Zahl unterstreicht, wie zentral die korrekte Auswahl und Konfiguration von Cloud-Diensten für die Compliance geworden ist. Einen tieferen Einblick in die Entwicklungen auf dem deutschen Cloud-Computing-Markt bietet diese Analyse. Letztendlich ist die Entscheidung für Cloud oder On-Premise immer eine strategische Abwägung zwischen der Übernahme der vollen Verantwortung und dem Management der Risiken, die mit Drittanbietern einhergehen.

Performance-Realitätscheck: Wo Cloud vs. On-Premise wirklich steht

Die Debatte über die Performance im Duell Cloud vs. On-Premise wird oft von synthetischen Benchmarks beeinflusst, die wenig über die Leistung im echten Geschäftsalltag aussagen. Isolierte Tests spiegeln selten die Komplexität wider, die in einer realen Unternehmensumgebung herrscht. Die Performance hängt letztlich weniger vom gewählten Bereitstellungsmodell ab als von der Architektur Ihrer Anwendungen und den spezifischen Arbeitslasten. Obwohl die Cloud eine beeindruckende Skalierbarkeit bietet, kann eine hohe Netzwerklatenz die Produktivität bei bestimmten Anwendungen stark beeinträchtigen.

Nehmen wir als Beispiel ein datenbankintensives ERP-System. In der Cloud ist die Rechenleistung praktisch unbegrenzt verfügbar. Die Latenz zwischen dem Anwender und der Cloud-Datenbank kann jedoch die gefühlte Reaktionszeit erheblich verlangsamen. Jede Millisekunde Verzögerung summiert sich über Tausende täglicher Transaktionen zu spürbaren Wartezeiten. Eine On-Premise-Infrastruktur, bei der sich Datenbank und Client im selben lokalen Netzwerk befinden, liefert hier oft eine überlegene Nutzererfahrung, selbst wenn die reine Rechenleistung auf dem Papier geringer ist. Studien deuten darauf hin, dass eine Latenz von über 100 Millisekunden die Zufriedenheit der Nutzer bereits deutlich reduziert.

Workload-Analyse: Wo Cloud und On-Premise brillieren

Nicht jede Anwendung profitiert gleichermaßen von der zugrunde liegenden Infrastruktur. Um eine optimale Performance zu erreichen, müssen die richtigen Workloads am richtigen Ort platziert werden.

- Stärken der Cloud: Ideal für Anwendungen, die für eine verteilte Architektur entwickelt wurden. Dazu zählen containerisierte Microservices, Web-Anwendungen mit einer globalen Nutzerbasis und KI-Workloads, die kurzfristig massive Rechenleistung benötigen. Die Fähigkeit, Ressourcen bei Lastspitzen automatisch zu skalieren (Auto-Scaling), ist hier ein entscheidender Vorteil.

- Stärken von On-Premise: Monolithische Anwendungen, die eine extrem niedrige Netzwerklatenz erfordern, laufen häufig besser auf einer lokalen Infrastruktur. Beispiele hierfür sind Echtzeit-Fertigungssteuerungssysteme (MES), Hochfrequenz-Handelssysteme oder die Bearbeitung großer, unstrukturierter Videodateien, bei denen der Transfer riesiger Datenmengen in die Cloud zu langsam und kostspielig wäre.

Die Rolle der Anwendungsarchitektur

Die Architektur einer Anwendung ist heute ein zentraler Faktor für ihre Performance. Cloud-native Anwendungen sind von Grund auf so konzipiert, dass sie Ausfälle tolerieren und horizontal skalieren können – eine Eigenschaft, die in traditionellen On-Premise-Umgebungen nur schwer nachzubilden ist. Die folgende Abbildung zeigt eine gut strukturierte Cloud-Architektur am Beispiel von AWS.

Das Diagramm zeigt, wie unterschiedliche Cloud-Dienste – von Recheninstanzen über Datenbanken bis hin zu Caching-Layern – intelligent miteinander verknüpft werden, um hohe Verfügbarkeit und Skalierbarkeit zu sichern. Diese modulare Bauweise ist der Kern moderner, performanter Cloud-Systeme und unterscheidet sich grundlegend von traditionellen, monolithischen On-Premise-Setups.

Monitoring, das wirklich zählt

Um Leistungsprobleme effektiv vorhersagen zu können, müssen die richtigen Kennzahlen überwacht werden. Statt nur die CPU-Auslastung im Blick zu haben, sind in einer Cloud-Umgebung Metriken wie Netzwerklatenz, API-Antwortzeiten und Datenbank-Query-Zeiten von größerer Bedeutung. Bei On-Premise-Systemen bleiben hingegen Engpässe bei der Speicher-I/O und der Netzwerkbandbreite die kritischsten Punkte.

Eine Technologie, die diese Gleichung zunehmend verändert, ist das Edge Computing. Dabei werden Rechenressourcen näher an den Endnutzer oder die Datenquelle verlagert. Dies umgeht die Latenzprobleme der Cloud, ohne dass eine vollständige On-Premise-Infrastruktur notwendig wird. Für latenzkritische IoT- und Industrie-4.0-Anwendungen stellt dies einen vielversprechenden Mittelweg dar und verdeutlicht, dass die Zukunft der Performance oft in hybriden Ansätzen liegt.

Branchenspezifische Entscheidungshilfen: Was für wen funktioniert

Die Entscheidung zwischen Cloud und On-Premise ist niemals eine Pauschallösung. Sie hängt stark von den individuellen Anforderungen und den regulatorischen Rahmenbedingungen einer Branche ab. Was für ein agiles Fintech-Unternehmen die ideale Wahl ist, kann für einen etablierten Maschinenbauer mit jahrzehntelanger Produktionsgeschichte ein strategischer Fehler sein. Eine genauere Betrachtung branchenspezifischer Muster zeigt, dass erfolgreiche Unternehmen ihre Infrastruktur nicht nach allgemeinen Trends, sondern nach ihren Kernprozessen ausrichten.

Nehmen wir zum Beispiel Banken und Versicherungen, die unter der strengen Aufsicht von Regulierungsbehörden wie der BaFin stehen. Hier ist der nachweisbare Datenstandort und lückenlose Compliance der entscheidende Faktor. Traditionell setzten diese Branchen auf On-Premise-Lösungen, um die volle Kontrolle zu behalten. Inzwischen greifen sie jedoch vermehrt auf Private-Cloud-Modelle oder zertifizierte Anbieter zurück, die branchenspezifische Anforderungen erfüllen. Ein typischer Fehler besteht darin, die Komplexität der Cloud-Compliance zu unterschätzen.

Im starken Kontrast dazu steht die produzierende Industrie, insbesondere der deutsche Maschinenbau, die mit der Verarbeitung gewaltiger Datenmengen aus dem Internet der Dinge (IoT) konfrontiert ist. Hier stehen Performance und die Verarbeitung von Echtzeitdaten im Mittelpunkt. Sensordaten von Produktionsanlagen müssen mit minimaler Latenz analysiert werden, um Ausfälle vorhersagen zu können. Eine On-Premise-Lösung, oft durch Edge Computing ergänzt, ist in diesem Fall oft überlegen, da der Datentransfer in eine Public Cloud zu langsam und kostspielig wäre. Ein häufiger Irrtum ist es, IoT-Daten ohne eine klare Strategie in eine generische Cloud zu senden, was hohe Kosten bei geringem Nutzen verursacht.

Branchenspezifische Entscheidungsmatrix

Um diese kritischen Faktoren zu verdeutlichen, fasst die folgende Matrix Empfehlungen zusammen, die auf Analysen und Interviews mit Branchenexperten beruhen. Sie dient als praktische Orientierungshilfe, um typische Fallstricke bei der Infrastrukturwahl zu umgehen.

| Branchenspezifische Entscheidungsmatrix Strategische Bewertung basierend auf 50 Branchenexperten-Interviews |

|||

|---|---|---|---|

| Branche | Kritischer Erfolgsfaktor | Häufigster Fehler | Empfohlener Ansatz |

| Finanzdienstleistungen | Regulatorische Compliance & Datenhoheit | Unzureichende Due-Diligence bei Cloud-Anbietern | Hybrid-Cloud oder zertifizierte Private Cloud |

| Gesundheitswesen | Hohe Verfügbarkeit & Schutz von Patientendaten (ePA) | Vernachlässigung der physischen Sicherheit bei On-Premise | Hybrid-Ansatz für Redundanz und Datensicherheit |

| Produzierendes Gewerbe/Industrie 4.0 | Geringe Latenz für Produktionssteuerung (MES/IoT) | Versuch, alle Echtzeitdaten in die Public Cloud zu verlagern | On-Premise mit Edge-Komponenten; Cloud für Analysen |

| E-Commerce & Handel | Skalierbarkeit für Lastspitzen (z. B. Black Friday) | Mangelnde Automatisierung und Überdimensionierung | Public Cloud (IaaS/PaaS) für maximale Flexibilität |

Die Beispiele verdeutlichen, dass die Wahl der Infrastruktur eine direkte Konsequenz aus dem Geschäftsmodell und den operativen Gegebenheiten ist. Während ein E-Commerce-Händler ohne die Skalierbarkeit der Cloud kaum wettbewerbsfähig wäre, könnte ein produzierendes Unternehmen mit einer reinen Cloud-Strategie für seine Kernprozesse ins Hintertreffen geraten. Eine solide Entscheidung erfordert daher eine tiefgehende Analyse der eigenen Branche und ihrer spezifischen Herausforderungen. Weitere Einblicke und Hilfestellungen finden Sie in unserem weiterführenden Artikel über verschiedene Cloud-Lösungen für Unternehmen.

Hybrid-Strategien: Warum die Zukunft nicht schwarz-weiß ist

Die starre Debatte „Cloud vs. On-Premise“ gehört für die meisten fortschrittlichen Unternehmen der Vergangenheit an. Statt eine Entweder-oder-Frage zu stellen, formulieren sie sie neu: Welcher Workload läuft wann und wo am besten? Diese Denkweise führt direkt zu Hybrid- und Multi-Cloud-Strategien. Solche Ansätze sind zwar komplexer, liefern aber pragmatische Lösungen für reale Geschäftsprobleme und vermeiden eine Unterwerfung unter ein technologisches Dogma. Der Erfolg liegt nicht in der Wahl einer einzigen Plattform, sondern in der intelligenten Orchestrierung verschiedener Infrastrukturen.

Was-wo-wann: Die Kunst der intelligenten Workload-Verteilung

Der Schlüssel zu einer erfolgreichen Hybrid-Implementierung ist eine genaue Analyse der eigenen Anwendungslandschaft. Nicht jede Anwendung ist für jede Umgebung gleichermaßen gut geeignet. Erfolgreiche deutsche Unternehmen verteilen ihre Workloads strategisch, um die spezifischen Stärken von Cloud und On-Premise gezielt zu nutzen.

- Beständigkeit und Kontrolle (On-Premise): Kerngeschäftsanwendungen wie ERP- oder MES-Systeme, die eine extrem niedrige Latenz und absolute Datenhoheit erfordern, bleiben oft auf der eigenen Infrastruktur. Hier haben Unternehmen die volle Kontrolle über Leistung und Sicherheit.

- Flexibilität und Innovation (Cloud): Anwendungen mit stark schwankender Auslastung, etwa kundenorientierte Web-Portale oder Umgebungen für Entwicklung und Tests, profitieren von der bedarfsgerechten Skalierbarkeit der Cloud. Rechenintensive Aufgaben wie Big-Data-Analysen oder das Training von KI-Modellen werden ebenfalls oft in die Cloud ausgelagert.

- Szenario „Cloud Bursting“: Dies ist ein klassisches Hybrid-Modell. Die alltägliche Grundlast einer Anwendung wird kosteneffizient auf der On-Premise-Infrastruktur verarbeitet. Kommt es zu unerwarteten Lastspitzen, zum Beispiel durch eine Marketingkampagne, werden zusätzliche Ressourcen nahtlos aus der Public Cloud zugeschaltet.

Die Schattenseiten: Komplexität und Management-Overhead

Trotz der klaren Vorteile darf die Komplexität einer hybriden Umgebung nicht unterschätzt werden. Die Verwaltung von Ressourcen, Sicherheitsprotokollen und Kosten über verschiedene Plattformen hinweg kann IT-Teams schnell an ihre Grenzen bringen. Ohne die passenden Management-Werkzeuge und ein klares Governance-Modell drohen Kontrollverlust und explodierende Kosten. Entscheidend für den Erfolg ist daher der Einsatz zentraler Orchestrierungsplattformen, die eine einheitliche Sicht auf alle Ressourcen ermöglichen.

Ein zentraler Baustein für echte Portabilität in solchen Umgebungen sind Container-Technologien wie Docker und Kubernetes. Sie erlauben es, Anwendungen samt ihrer Abhängigkeiten zu bündeln und sie konsistent zwischen On-Premise-Servern und verschiedenen Cloud-Anbietern zu verschieben. Dieser Ansatz reduziert den gefürchteten Vendor-Lock-in und gibt Unternehmen ihre strategische Freiheit zurück. Die zunehmende Relevanz dieser flexiblen Modelle zeigt sich auch im Marktwachstum. Prognosen deuten darauf hin, dass der deutsche Cloud-Markt bis 2030 mit einer jährlichen Rate von 15,51 % wachsen wird. Mehr zu dieser Entwicklung erfahren Sie in der Analyse des deutschen Cloud-Marktes von Mordor Intelligence. Letztendlich bestätigt die Praxis, dass die Zukunft der IT-Infrastruktur kein Schwarz-Weiß-Bild ist, sondern ein intelligent orchestriertes Mosaik aus verschiedenen, passgenauen Lösungen.

Ihr strategischer Entscheidungsrahmen: So treffen Sie die richtige Wahl

Die Entscheidung zwischen Cloud und On-Premise sollte niemals aus dem Bauch heraus getroffen werden. IT-Führungskräfte, die erfolgreich agieren, verlassen sich auf einen strukturierten Prozess, der weit über einfache Pro-und-Kontra-Listen hinausgeht. Dieser Rahmen verknüpft die Geschäftsstrategie, die Risikotoleranz und die Zukunftspläne des Unternehmens, um eine fundierte und nachhaltige Entscheidung zu treffen. Anstatt einfach nur Trends zu folgen, wird die Wahl der Infrastruktur so zu einem bewusst gestalteten Werkzeug, das die Unternehmensziele unterstützt.

Schritt 1: Stakeholder-Analyse und Zieldefinition

Der erste und vielleicht wichtigste Schritt ist die Identifizierung und Einbindung aller relevanten Stakeholder. Eine rein IT-getriebene Entscheidung ist oft zum Scheitern verurteilt, da sie die spezifischen Bedürfnisse anderer Abteilungen außer Acht lässt.

- Finanzabteilung (CFO): Diese Abteilung bringt die Perspektive der Gesamtkosten (TCO), des Cashflows (CapEx vs. OpEx) und der finanziellen Risiken ein.

- Fachabteilungen (z. B. Vertrieb, Produktion): Sie definieren die konkreten Anforderungen an Performance, Verfügbarkeit und spezielle Funktionalitäten, die für ihren Betrieb entscheidend sind.

- Rechts- und Compliance-Abteilung: Hier werden die Risiken in Bezug auf Datenschutz (DSGVO), branchenspezifische Vorschriften und vertragliche Verpflichtungen bewertet.

- Geschäftsführung (CEO): Sie stellt sicher, dass die Entscheidung die übergeordnete Unternehmensstrategie, wie Expansionspläne oder Innovationsziele, aktiv unterstützt.

In einem gemeinsamen Workshop lassen sich die Ziele am besten priorisieren. Geht es primär um Kostensenkung, Agilität, maximale Sicherheit oder Skalierbarkeit? Eine klare Definition dieser Prioritäten verhindert spätere Missverständnisse und Konflikte.

Schritt 2: Entwicklung einer Bewertungsmatrix

Um einen objektiven Vergleich zu ermöglichen, sollten Sie eine Bewertungsmatrix erstellen. Diese gewichtet die zuvor definierten Kriterien entsprechend ihrer strategischen Bedeutung für Ihr spezifisches Unternehmen. Das ist der entscheidende Unterschied zu einer generischen Checkliste, da sie Ihre individuellen Prioritäten abbildet.

| Kriterium | Gewichtung (1-5) | Cloud-Score (1-10) | On-Premise-Score (1-10) | Cloud (gewichtet) | On-Premise (gewichtet) |

|---|---|---|---|---|---|

| Anfangsinvestition (CapEx) | 3 | 9 | 2 | 27 | 6 |

| Skalierbarkeit bei Lastspitzen | 5 | 10 | 4 | 50 | 20 |

| Datenkontrolle & -hoheit | 4 | 6 | 10 | 24 | 40 |

| Laufende Betriebskosten (OpEx) | 4 | 5 | 8 | 20 | 32 |

| Time-to-Market für neue Dienste | 5 | 9 | 3 | 45 | 15 |

| Gesamtscore | 166 | 113 |

Eine solche Matrix macht den Entscheidungsprozess transparent und für alle Beteiligten nachvollziehbar. Sie zwingt dazu, Annahmen zu quantifizieren und emotionale Argumente durch faktenbasierte Bewertungen zu ersetzen.

Schritt 3: Die Entscheidung zukunftssicher machen

Die finale Entscheidung im Spannungsfeld Cloud vs. On-Premise ist selten für die Ewigkeit. Um als Unternehmen agil zu bleiben, müssen Sie von vornherein Flexibilität einplanen. Definieren Sie klare Auslöser für eine Neubewertung, wie zum Beispiel eine Änderung der Geschäftsstrategie, eine bedeutende technologische Entwicklung oder das Erreichen einer bestimmten Unternehmensgröße. Ein hybrider Ansatz kann hier als Brücke dienen, die es erlaubt, Workloads bei Bedarf zu verschieben.

Achten Sie auf Warnsignale, die auf eine suboptimale Entscheidung hindeuten. Dazu gehören unerwartet hohe Cloud-Rechnungen, Performance-Engpässe bei kritischen Anwendungen oder zunehmende Schwierigkeiten bei der Einhaltung von Compliance-Vorgaben. Ein regelmäßiges Monitoring dieser Kennzahlen ermöglicht es Ihnen, rechtzeitig gegenzusteuern, bevor kostspielige Fehlentwicklungen entstehen.

Eine strategische IT-Entscheidung erfordert Weitblick und einen erfahrenen Partner. Die Deeken.Technology GmbH unterstützt Sie als ISO 27001-zertifiziertes Systemhaus dabei, den richtigen Rahmen für Ihre Infrastruktur zu schaffen – von der Analyse über die Implementierung bis zur Optimierung. Kontaktieren Sie uns für eine fundierte Beratung und eine zukunftssichere IT-Strategie.

20.06.2025 10:08:07

Comments