Kategorien:

Was ist Virtualisierung? Einfach erklärt & Vorteile entdecken

Was ist Virtualisierung? Stellen Sie sich vor, Sie könnten einen einzigen physischen Computer so aufteilen, dass er sich wie mehrere separate Rechner verhält. Genau das ist der Kern von Virtualisierung. Statt für jede einzelne Aufgabe eine eigene Maschine anzuschaffen, erschafft diese Technologie mehrere voneinander unabhängige, virtuelle Umgebungen auf ein und derselben Hardware.

Wie Virtualisierung die IT von Grund auf verändert

Malen wir uns das einmal aus: Ihr Unternehmen wächst, und jede Abteilung braucht ihre eigene IT-Umgebung. Nach dem alten Modell würden Sie jetzt für jede Abteilung einen eigenen Server kaufen – quasi für jeden ein eigenes kleines Bürogebäude errichten. Das ist nicht nur unglaublich teuer, sondern auch ineffizient, denn die meisten dieser Server (also die Gebäude) wären die meiste Zeit über kaum ausgelastet.

Virtualisierung geht hier einen viel clevereren Weg. Anstatt vieler kleiner Gebäude mieten Sie ein großes Bürohochhaus – sprich, einen leistungsstarken Server – und teilen es in flexible, passgenaue Büroeinheiten auf. Jede dieser Einheiten ist eine virtuelle Maschine (VM), also eine komplett isolierte, digitale Kopie eines Computers mit eigenem Betriebssystem und eigenen Anwendungen.

Das Kernprinzip: Effizienz und Flexibilität

Diese Methode krempelt die Art und Weise, wie wir Hardware nutzen, komplett um. Sie bündelt Rechenleistung, Speicherplatz und Netzwerkfähigkeiten in einem großen, zentralen Pool. Aus diesem Pool können Sie dann exakt die Ressourcen herauspicken, die Sie für eine bestimmte Aufgabe brauchen, und sie einer VM zuweisen.

Dieser Ansatz ist in der deutschen Unternehmens-IT längst kein Geheimtipp mehr. Schon 2015 setzten über 70 % der großen Unternehmen auf Virtualisierung, um ihre Hardware endlich richtig auszunutzen. Im Schnitt konnten sie so die Auslastung ihrer Server um 60–70 % steigern und ganz nebenbei die Energiekosten im Rechenzentrum um bis zu 30 % senken. Auf oeffentliche-it.de können Sie mehr über die zentrale Rolle der Virtualisierung bei der Digitalisierung Deutschlands nachlesen.

Virtualisierung ist weit mehr als eine technische Spielerei. Sie ist ein strategisches Werkzeug, das Unternehmen hilft, ihre IT agiler, kosteneffizienter und robuster aufzustellen.

Die Vorteile liegen auf der Hand:

- Maximale Ressourcennutzung: Anstatt dass mehrere Server bei 15 % Auslastung vor sich hin dümpeln, läuft ein einziger Server auf 80 % und erledigt die Arbeit von allen.

- Enorme Kosteneinsparungen: Weniger Hardware bedeutet weniger Ausgaben für Anschaffung, Strom und Kühlung. So einfach ist das.

- Gesteigerte Agilität: Ein neuer virtueller Server ist in Minuten startklar, nicht erst nach Wochen, in denen auf die Lieferung von Hardware gewartet wird.

Mit diesem Grundverständnis im Gepäck können wir uns nun die weitreichenden Vorteile und konkreten Anwendungsfälle genauer ansehen, die durch diese Technologie erst möglich werden.

Die technologie hinter der virtualisierung

Um zu verstehen, was hinter der Virtualisierung steckt, müssen wir einen Blick auf die Kernkomponenten werfen. Das absolute Herzstück dieser Technologie ist der Hypervisor. Man kann ihn sich am besten als eine Art intelligenten Regisseur oder Übersetzer vorstellen, der zwischen der physischen Hardware – also dem echten, greifbaren Computer – und den virtuellen Maschinen (VMs) sitzt.

Seine Hauptaufgabe ist es, die physischen Ressourcen wie CPU-Leistung, Arbeitsspeicher und Festplattenplatz clever zu verwalten. Er teilt sie den einzelnen virtuellen Maschinen genau so zu, wie sie es gerade brauchen. Dadurch schafft er die entscheidende Entkopplung: Die VMs arbeiten parallel, ohne überhaupt zu wissen, dass sie sich die Hardware teilen, und stören sich so nicht gegenseitig.

Die zwei arten von hypervisoren

Je nachdem, wie der Hypervisor aufgesetzt wird, unterscheidet man zwischen zwei grundlegenden Typen. Jeder hat seine eigenen Stärken und ist für unterschiedliche Einsatzszenarien optimiert.

Typ-1-Hypervisor (Bare Metal): Dieser Typ wird direkt auf der „nackten“ physischen Hardware installiert – ganz ohne ein Betriebssystem als Zwischenschicht. Man spricht deshalb auch von "Bare Metal". Er hat direkten Zugriff auf alle Ressourcen, was ihn extrem schnell und effizient macht. Genau deshalb ist dieser Ansatz der Goldstandard in professionellen Rechenzentren, wo es auf maximale Leistung und Stabilität ankommt. Bekannte Beispiele sind hier VMware vSphere oder Microsoft Hyper-V.

Typ-2-Hypervisor (Hosted): Im Gegensatz dazu wird dieser Typ wie eine ganz normale Anwendung auf einem bestehenden Betriebssystem (zum Beispiel Windows, macOS oder Linux) installiert. Das macht ihn perfekt für Entwickler, die auf ihrem Laptop schnell mal eine Testumgebung aufsetzen wollen. Genauso praktisch ist er für Anwender, die einfach ein zweites Betriebssystem ausprobieren möchten, ohne ihre Festplatte neu aufteilen zu müssen. Gängige Programme hierfür sind Oracle VirtualBox oder VMware Workstation.

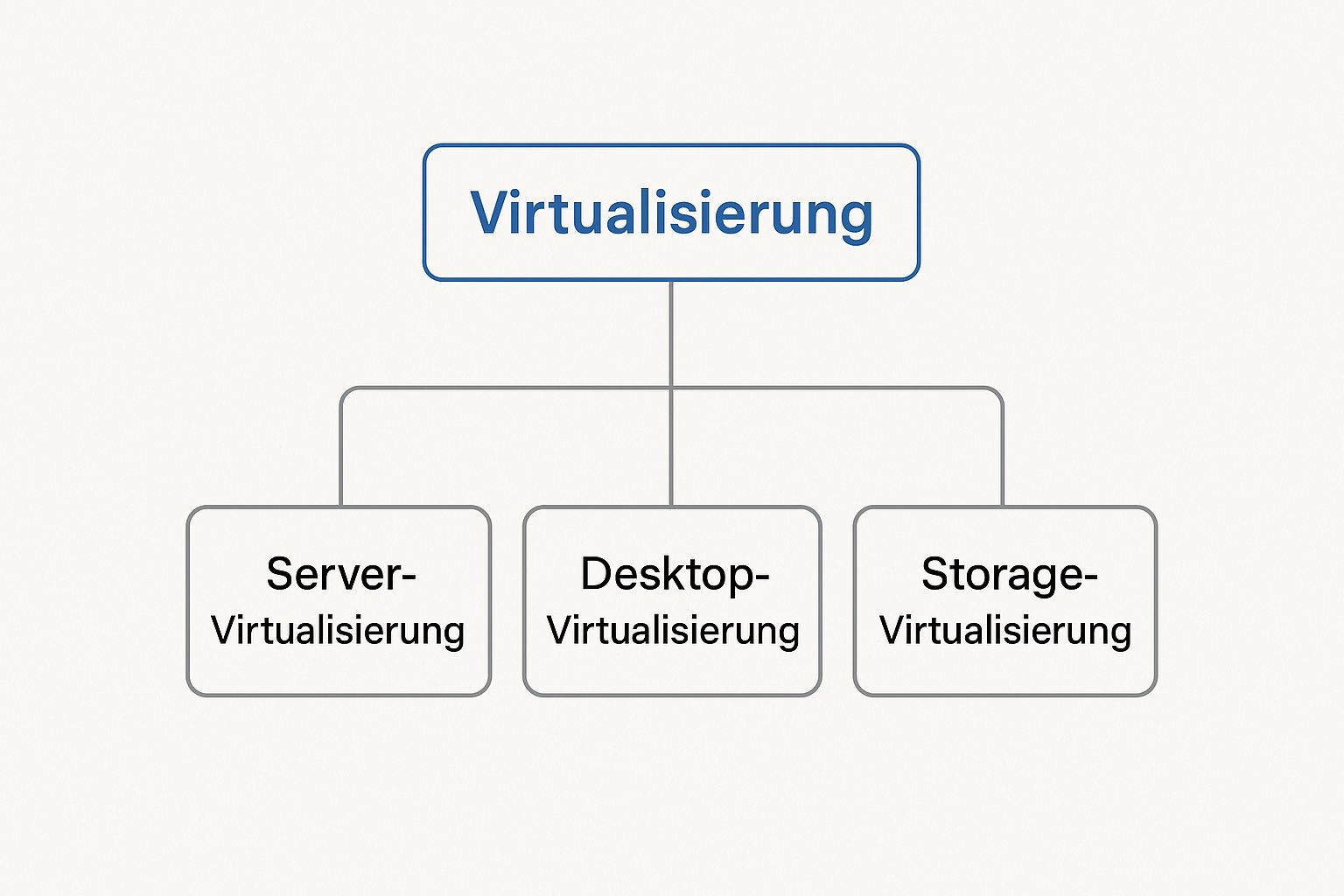

Die folgende Übersicht zeigt, dass Virtualisierung weit mehr als nur Server betrifft und verschiedene Bereiche der IT-Infrastruktur umfassen kann.

Diese Grafik verdeutlicht schön, dass neben Servern auch Desktops, Speicher und sogar Netzwerke virtualisiert werden können, um eine durchweg flexible und zentral verwaltete IT-Landschaft zu schaffen.

Welcher hypervisor ist der richtige?

Die Wahl des passenden Hypervisors hängt immer zu 100 % vom Anwendungsfall ab. Ein Typ-2-Hypervisor ist die perfekte Wahl für lokale Entwicklungs- und Testzwecke auf einem einzelnen Rechner. Ihn aber für eine geschäftskritische Anwendung im Rechenzentrum zu nutzen, wäre völlig ungeeignet.

Dort ist die überlegene Leistung, Sicherheit und Effizienz eines Typ-1-Hypervisors schlichtweg unverzichtbar.

Der Hypervisor ist die magische Zutat, die Virtualisierung überhaupt erst möglich macht. Er legt eine Abstraktionsschicht über die Hardware und verwandelt starre, physische Ressourcen in flexible, virtuelle Bausteine.

Um die Entscheidung zu erleichtern, haben wir die beiden Ansätze in einer Tabelle direkt gegenübergestellt.

Vergleich der hypervisor-typen

Diese Tabelle stellt die wesentlichen Unterschiede, Vorteile und Anwendungsfälle von Typ-1- (Bare Metal) und Typ-2- (Hosted) Hypervisoren gegenüber.

| Merkmal | Typ-1-Hypervisor (Bare Metal) | Typ-2-Hypervisor (Hosted) |

|---|---|---|

| Architektur | Läuft direkt auf der physischen Hardware | Läuft als Anwendung auf einem Host-Betriebssystem |

| Leistung | Sehr hoch, da direkter Hardwarezugriff | Geringer, da Ressourcen mit dem Host-OS geteilt werden |

| Sicherheit | Höher, da weniger Angriffspunkte | Potenziell anfälliger, da vom Host-OS abhängig |

| Einsatzgebiet | Rechenzentren, Cloud-Infrastruktur, Serverkonsolidierung | Desktop-Nutzung, Entwicklung, Testumgebungen |

| Beispiele | VMware vSphere, Microsoft Hyper-V, KVM | Oracle VirtualBox, VMware Workstation, Parallels Desktop |

Letztendlich entscheidet das Ziel über den Weg. Für den unkomplizierten Einstieg und zum Experimentieren ist ein Typ-2-Hypervisor ideal. Sobald es aber professionell wird, führt kaum ein Weg an den robusten Typ-1-Lösungen vorbei.

Wo Virtualisierung in der Praxis wirklich glänzt

Die Frage „Was ist Virtualisierung?“ führt uns schnell weg von der grauen Theorie und mitten rein in handfeste, praktische Lösungen. Die wahre Kraft dieser Technologie zeigt sich nämlich erst in den unzähligen Anwendungsfällen, in denen sie IT-Landschaften spürbar effizienter, beweglicher und günstiger macht. Unternehmen setzen sie nicht aus Selbstzweck ein, sondern als gezieltes Werkzeug, um ganz konkrete Probleme zu lösen.

Heute ist die Technologie ein echtes Fundament der modernen IT. Ihre Einsatzmöglichkeiten sind so breit gefächert, dass fast jede Branche davon profitiert, indem sie Hardware-Ressourcen clever bündelt und genau dorthin lenkt, wo sie gebraucht werden.

Serverkonsolidierung im rechenzentrum

Der wohl bekannteste und klassischste Anwendungsfall ist die Serverkonsolidierung. Früher war es ganz normal: Jede Anwendung bekam ihren eigenen, dedizierten Server. Das Problem? Die meiste Zeit dümpelten diese Maschinen nur bei einem Bruchteil ihrer möglichen Auslastung vor sich hin. Eine enorme Verschwendung von Geld, Platz im Serverraum und Energie.

Dank Servervirtualisierung sieht die Welt heute ganz anders aus. Auf einem einzigen, leistungsstarken physischen Server können jetzt Dutzende virtuelle Maschinen (VMs) parallel laufen. Statt zehn kaum genutzter Kisten arbeitet eine einzige auf Hochtouren. Das Ergebnis ist eine drastische Senkung der Kosten für Hardware, Strom und Kühlung und obendrein ein viel einfacheres Management.

Virtualisierung bricht die starre Eins-zu-eins-Beziehung zwischen Anwendung und Hardware auf. Sie schafft einen flexiblen Pool an Ressourcen, der dynamisch dort eingesetzt wird, wo er gerade gebraucht wird.

Eng mit der Serverkonsolidierung verknüpft ist eine weitere strategische Entscheidung: Wo soll diese virtualisierte Infrastruktur eigentlich laufen? Lokal im eigenen Rechenzentrum oder doch lieber in der Cloud? Um Ihnen diese wichtige Entscheidung zu erleichtern, haben wir die wichtigsten Aspekte für Sie aufbereitet. Erfahren Sie mehr über die Unterschiede zwischen Cloud und On-Premise in unserem detaillierten Blogartikel.

Desktop- und anwendungsvirtualisierung

Virtualisierung macht aber keineswegs bei Servern halt. Die Desktopvirtualisierung, oft als Virtual Desktop Infrastructure (VDI) bezeichnet, krempelt die Art und Weise um, wie Mitarbeiter auf ihre Arbeitsumgebung zugreifen. Anstatt dass jeder Kollege einen physischen PC unter dem Schreibtisch hat, werden die einzelnen Desktops zentral auf einem Server im Rechenzentrum bereitgestellt.

Mitarbeiter können sich dann von jedem beliebigen Gerät aus – sei es der Laptop im Homeoffice oder das Tablet von unterwegs – sicher mit ihrem persönlichen, virtuellen Desktop verbinden. Das bringt gewaltige Vorteile mit sich:

- Zentrale Verwaltung: Software-Updates und Sicherheitspatches? Die müssen nur einmal auf dem zentralen „Master-Image“ installiert werden und stehen sofort allen Nutzern zur Verfügung. Kein mühsames Aktualisieren einzelner Rechner mehr.

- Erhöhte Sicherheit: Sensible Firmendaten verlassen nie das sichere Rechenzentrum. Auf die Endgeräte wird lediglich der Bildschirminhalt übertragen – die Daten selbst bleiben geschützt.

- Flexibilität und Mobilität: Mitarbeiter haben von überall und zu jeder Zeit Zugriff auf ihre vertraute Arbeitsumgebung. Das ist die Basis für modernes, ortsunabhängiges Arbeiten.

Netzwerk- und speichervirtualisierung

Zu guter Letzt gibt es noch zwei weitere, etwas fortgeschrittenere Einsatzgebiete, die aber nicht weniger wichtig sind:

- Netzwerkvirtualisierung: Hier werden physische Netzwerkkomponenten wie Switches und Router durch Software nachgebildet. Das klingt technisch, ermöglicht aber etwas sehr Mächtiges: die Schaffung komplett isolierter, virtueller Netzwerke auf einer gemeinsamen physischen Infrastruktur. Die Sicherheit und Flexibilität steigen dadurch enorm.

- Speichervirtualisierung: Bei diesem Ansatz werden Speicherressourcen aus ganz unterschiedlichen physischen Systemen (also mehreren Festplatten-Arrays) zu einem einzigen, zentral verwalteten Speicherpool zusammengefasst. Administratoren können diesen Speicher dann nach Bedarf flexibel den einzelnen virtuellen Maschinen zuweisen, ohne sich über die komplexe Hardware darunter den Kopf zerbrechen zu müssen.

Greifbare vorteile für unternehmen und anwender

Warum ist die Virtualisierung für so viele Unternehmen zu einem unverzichtbaren Werkzeug geworden? Die Antwort liegt in den handfesten, messbaren Vorteilen, die weit über technische Spielereien hinausgehen. Im Kern geht es darum, mehr aus der vorhandenen Hardware herauszuholen – und das wirkt sich direkt auf das Budget und die täglichen Abläufe aus.

Der wohl offensichtlichste Gewinn ist die drastische Kostensenkung. Anstatt einen ganzen Park physischer Server zu kaufen, die alle Strom fressen, gekühlt und gewartet werden müssen, bündeln Unternehmen ihre Systeme auf wenigen, aber dafür optimal ausgelasteten Maschinen. Das spart nicht nur bei der Anschaffung, sondern senkt auch die laufenden Betriebskosten spürbar.

Agilität und skalierbarkeit auf knopfdruck

Neben den reinen Kosteneinsparungen ist die gewonnene Agilität ein entscheidender Wettbewerbsvorteil. In traditionellen IT-Umgebungen dauert es oft Wochen, einen neuen Server bereitzustellen. Hardware muss bestellt, geliefert, aufgebaut und konfiguriert werden. Ein echter Bremsklotz.

In einer virtualisierten Umgebung schrumpft dieser Prozess auf wenige Minuten. Ein neuer virtueller Server für eine Testumgebung oder eine neue Anwendung? Mit ein paar Klicks ist er geklont oder neu erstellt. Diese Fähigkeit, schnell zu skalieren, erlaubt es Unternehmen, sofort auf neue Marktanforderungen oder Projektideen zu reagieren, ohne von langwierigen IT-Prozessen ausgebremst zu werden.

Virtualisierung wandelt eine starre, physische Infrastruktur in einen flexiblen Baukasten um. Ressourcen werden dynamisch dort eingesetzt, wo sie den größten Nutzen stiften – sei es für Kosteneffizienz, schnelle Entwicklung oder Ausfallsicherheit.

Verbesserte ausfallsicherheit und disaster recovery

Ein weiterer zentraler Vorteil ist die erhöhte Ausfallsicherheit. Virtuelle Maschinen (VMs) sind im Grunde nichts anderes als große Dateien, die auf einem Speichersystem liegen. Genau diese Eigenschaft macht Backup- und Wiederherstellungsprozesse radikal einfacher. Man kann eine komplette VM problemlos sichern, kopieren und auf eine andere physische Maschine verschieben.

Diese Unabhängigkeit von der Hardware ist das Fundament für robuste Disaster-Recovery-Strategien:

- Schnelle Wiederherstellung: Fällt ein physischer Server aus, kann die darauf laufende VM binnen Minuten auf einem anderen Host neu gestartet werden – oft sogar vollautomatisch.

- Einfache Tests: Man kann Wiederherstellungsszenarien regelmäßig und ohne Störung des laufenden Betriebs testen, indem man einfach eine Kopie der VM in einer isolierten Umgebung hochfährt.

- Geplante Wartung: Updates am physischen Server? Kein Problem. Die darauf laufenden VMs werden einfach im laufenden Betrieb auf einen anderen Host verschoben, ohne dass die Anwender eine Downtime bemerken.

Die Zentralisierung der IT-Verwaltung macht es auch leichter, Sicherheitsrichtlinien konsequent umzusetzen. Da alle VMs über einen zentralen Punkt gemanagt werden, lassen sich Sicherheitsstandards und Zugriffskontrollen einheitlich durchsetzen. Dieses Vorgehen ist ein wichtiger Baustein für eine sichere IT-Landschaft, wie sie beispielsweise für eine ISO 27001 Zertifizierung gefordert wird.

Ob es darum geht, alte Anwendungen zu modernisieren, die auf einer VM sicher weiterlaufen, oder getrennte Entwicklungs- und Produktivumgebungen zu schaffen – die praktischen Einsatzmöglichkeiten sind enorm. Das macht die Virtualisierung zu einer fundamentalen Säule moderner IT-Architekturen.

Virtualisierung in der Praxis erfolgreich umsetzen

Die Theorie hinter der Virtualisierung ist das eine, aber der wahre Wert zeigt sich erst, wenn die Technik im echten Unternehmensalltag ankommt. Wie also setzt man dieses Konzept erfolgreich in der Praxis um, um handfeste Probleme zu lösen? Der Schlüssel liegt darin, nicht einfach nur zu virtualisieren, sondern eine Strategie zu entwickeln, die genau auf die Bedürfnisse und Ziele des eigenen Unternehmens zugeschnitten ist.

Ein Paradebeispiel dafür ist der deutsche Mittelstand. Hier ist die Virtualisierung einer der wichtigsten Motoren für die digitale Transformation. Sie verschafft Unternehmen Zugang zu leistungsstarker IT, ohne dass sie Unsummen in physische Hardware investieren müssen. Statt teure Serverfarmen aufzubauen, können sie einfach und flexibel virtuelle Maschinen für neue Projekte, Testumgebungen oder die Modernisierung alter Anwendungen bereitstellen.

Ein Blick ins Gesundheitswesen

Besonders eindrucksvoll sind die Fortschritte im Gesundheitssektor. Virtualisierung ermöglicht hier die nötige Flexibilität für datenintensive Anwendungen wie elektronische Patientenakten oder Systeme für die medizinische Bildgebung. Die Fähigkeit, bei Bedarf blitzschnell zusätzliche Rechenleistung zur Verfügung zu stellen, ist in diesem Bereich absolut erfolgskritisch.

Ein aktuelles Beispiel zeigt die immense Bedeutung: Die Verbreitung von Virtualisierung im deutschen Gesundheitswesen ist regelrecht explodiert. Das spiegelt sich im rasanten Anstieg digitaler Arzt- und Videosprechstunden wider. Zwischen 2019 und 2023 stieg die Zahl der Videosprechstunden bei einer einzelnen großen Krankenkasse von wenigen hundert auf über eine halbe Million. Ein Großteil der Infrastruktur dahinter lief auf virtualisierten Servern, die es erlaubten, die extremen Nachfragespitzen während der Pandemie abzufedern. Mehr über die Herausforderungen der Digitalisierung in Deutschland erfahren Sie im Digital Kompass 2025.

Hürden bei der Implementierung

Trotz all der Vorteile ist die Einführung von Virtualisierung kein Spaziergang. Die Verwaltung einer virtualisierten Landschaft ist deutlich komplexer als der Betrieb einzelner physischer Server. Man braucht auf einmal tiefes Know-how in Bereichen wie Netzwerkmanagement, Speicherkonfiguration und vor allem Sicherheit.

Die größte Hürde ist oft nicht die Technik selbst, sondern der Mangel an Fachkräften, die diese Technik beherrschen. Eine erfolgreiche Virtualisierungsstrategie steht und fällt mit dem richtigen Expertenwissen.

Genau hier stoßen viele Unternehmen an ihre Grenzen. Der Fachkräftemangel in der IT ist ein altbekanntes Problem und kann eine vielversprechende Virtualisierungsinitiative schnell ausbremsen.

Für Unternehmen, die diese Expertise nicht im Haus haben, kann die Zusammenarbeit mit einem externen Partner die Lösung sein. Professionelle Managed IT-Services nehmen die Komplexität aus dem Spiel, stellen den reibungslosen Betrieb sicher und bringen das dringend benötigte Fachwissen ein. Lesen Sie in unserem Artikel, wie Sie durch Managed IT-Services Ihre IT-Abteilung entlasten und sich wieder voll auf Ihr Kerngeschäft konzentrieren können. Eine durchdachte Strategie, die den Bedarf an Experten von Anfang an berücksichtigt, ist am Ende der entscheidende Faktor für den langfristigen Erfolg.

Häufig gestellte fragen zur virtualisierung

Nachdem wir die Grundlagen, Technologien und Vorteile der Virtualisierung beleuchtet haben, bleiben oft noch ein paar konkrete Fragen im Raum stehen. Genau die wollen wir hier klären – kurz, praxisnah und auf den Punkt gebracht, damit Sie ein rundes Bild vom Thema bekommen.

Ist virtualisierung das gleiche wie die cloud?

Eine super Frage, denn die beiden Begriffe werden oft in einen Topf geworfen. Die Antwort ist: Nein, aber sie sind wie zwei Seiten derselben Medaille.

Man kann es sich so vorstellen: Virtualisierung ist die grundlegende Technologie, das technische Fundament. Cloud Computing hingegen ist das Geschäftsmodell, das auf dieser Technologie aufbaut.

- Virtualisierung schafft die virtuellen Bausteine – seien es virtuelle Maschinen (VMs), virtueller Speicher oder virtuelle Netzwerke. Es ist die reine Technik dahinter.

- Cloud Computing ist der Service, der diese virtualisierten Ressourcen bündelt und sie über ein Netzwerk (meist das Internet) flexibel und nach Bedarf bereitstellt.

Kurz gesagt: Ohne Virtualisierung gäbe es kein Cloud Computing, wie wir es heute kennen. Die Virtualisierung ist der Motor, die Cloud ist das Auto, das uns damit bequem von A nach B bringt.

Welche software brauche ich zum einstieg?

Um selbst einmal in die Welt der Virtualisierung einzutauchen, braucht man eine spezielle Software, einen sogenannten Hypervisor. Die gute Nachricht: Es gibt fantastische und kostenlose Werkzeuge, mit denen Sie direkt auf Ihrem eigenen PC loslegen können.

Für den Einsatz auf dem heimischen Schreibtisch (als Typ-2-Hypervisor) haben sich vor allem diese beiden bewährt:

- Oracle VM VirtualBox: Eine extrem beliebte Open-Source-Lösung, die auf Windows, macOS und Linux zu Hause ist.

- VMware Workstation Player: Die kostenlose Variante des Profi-Tools von VMware, perfekt für den nicht-kommerziellen Gebrauch.

Im professionellen Rechenzentrumsumfeld, wo es auf maximale Leistung und Stabilität ankommt, dominieren hingegen Typ-1-Hypervisoren. Hier sind Branchenführer wie VMware vSphere/ESXi, Microsoft Hyper-V (fest in Windows Server integriert) und der mächtige Open-Source-Hypervisor KVM (Kernel-based Virtual Machine) die erste Wahl.

Ist eine virtuelle maschine langsamer als ein physischer PC?

Diese Frage ist absolut berechtigt. Und ja, es gibt einen kleinen Leistungsverlust, den Experten als „Overhead“ bezeichnen. Er entsteht, weil der Hypervisor als vermittelnde Schicht zwischen der Hardware und der VM sitzt und selbst ein paar Ressourcen für die Verwaltung benötigt.

Wie stark dieser Effekt ausfällt, hängt aber ganz vom Typ des Hypervisors ab:

- Bei Typ-1-Hypervisoren (Bare-Metal), die direkt auf der Hardware laufen, ist dieser Overhead heutzutage minimal. Wir sprechen hier oft nur von wenigen Prozent – in der Praxis für die meisten Anwendungen absolut nicht spürbar.

- Bei Typ-2-Hypervisoren auf dem Desktop kann der Leistungsabfall etwas größer sein. Logisch, denn hier teilt sich die VM die Ressourcen direkt mit Ihrem normalen Betriebssystem.

Für die meisten Zwecke – ob zum Testen, für die Entwicklung oder den Betrieb von Standard-Software – ist die Leistung einer modernen VM aber mehr als ausreichend.

Der kleine Leistungs-Overhead wird durch die immense Flexibilität, die Kosteneinsparungen und die deutlich höhere Ausfallsicherheit, die Virtualisierung mit sich bringt, mehr als wettgemacht.

Was ist der unterschied zu containern wie docker?

Container und virtuelle Maschinen lösen auf den ersten Blick ein ähnliches Problem, gehen dabei aber fundamental andere Wege. Der entscheidende Unterschied liegt in der Ebene, auf der sie ansetzen.

- Eine virtuelle Maschine (VM) virtualisiert die komplette Hardware. Jede VM bringt ihr eigenes, vollwertiges Gastbetriebssystem mit. Das macht sie zwar ziemlich groß, aber auch extrem sicher und komplett isoliert vom Host und anderen VMs.

- Ein Container (wie bei Docker) virtualisiert hingegen nur auf Betriebssystemebene. Alle Container teilen sich denselben Systemkern des Hosts und packen nur die Anwendung selbst und ihre direkten Abhängigkeiten in ein isoliertes Päckchen.

Diese unterschiedliche Architektur hat direkte Folgen:

- Größe & Geschwindigkeit: Container sind winzig (oft nur wenige Megabyte) und starten in Sekundenbruchteilen. VMs können mehrere Gigabyte groß sein und brauchen Minuten zum Hochfahren.

- Ressourcenverbrauch: Weil sie sich den OS-Kern teilen, sind Container viel genügsamer. Sie brauchen deutlich weniger Arbeitsspeicher und CPU-Leistung als VMs.

- Isolation: VMs bieten die robustere Sicherheitsbarriere. Ein Problem im Betriebssystem einer VM kann einer anderen nichts anhaben, da sie komplett voneinander getrennt sind.

Die Wahl ist also klar: VMs sind perfekt für maximale Sicherheit und wenn man komplett unterschiedliche Betriebssysteme braucht. Container sind die Champions für schnelle, leichtgewichtige und skalierbare Anwendungsentwicklung.

Benötigen Sie einen zuverlässigen Partner, der die Komplexität der Virtualisierung für Sie managt und eine sichere, zukunftsfähige IT-Infrastruktur aufbaut? Deeken.Technology GmbH bietet als ISO 27001 zertifiziertes Systemhaus umfassende IT-Services von der Beratung bis zur Wartung. Entdecken Sie unsere IT-Lösungen.

01.08.2025 10:31:47

Comments