Was ist eine virtuelle Maschine (VM) überhaupt? Kurz gesagt: Eine virtuelle Maschine ist ein kompletter Computer, der nur aus Software besteht und auf einem physischen Rechner läuft. Sie benimmt sich dabei wie ein eigenständiges Gerät mit eigenem Betriebssystem und eigenen Programmen, teilt sich aber die Hardware – also Prozessorleistung, Arbeitsspeicher und Festplatte – mit dem Hauptcomputer, auch „Host“ genannt.

Ein computer in ihrem computer, sozusagen

Stellen Sie sich Ihren Server oder Laptop am besten wie ein großes Bürogebäude vor. Normalerweise nutzt eine einzige Firma (also ein Betriebssystem) das komplette Gebäude für sich allein. Mit einer virtuellen Maschine können Sie dieses Gebäude nun in viele kleinere, völlig unabhängige Büros unterteilen. In jedes dieser Büros kann eine andere Firma mit ihrer ganz eigenen Einrichtung einziehen – also ein anderes Betriebssystem wie Windows oder diverse Linux-Varianten.

Das Geniale daran: Diese „Büros“ wissen nichts voneinander. Sie arbeiten in vollständiger Isolation, obwohl sie sich dieselbe grundlegende Infrastruktur teilen. Genau diese strikte Trennung ist das Herzstück dessen, was VMs so unglaublich leistungsfähig und sicher macht.

Warum dieses konzept die IT revolutioniert hat

Diese Fähigkeit, Hardware-Ressourcen clever aufzuteilen und zu verwalten, hat die moderne IT von Grund auf verändert. Sie ist die technologische Basis für das gesamte Cloud-Computing und erlaubt es Unternehmen, ihre Infrastruktur viel effizienter zu nutzen. Anstatt für jede neue Anwendung einen teuren, physischen Server anzuschaffen, startet man einfach eine neue VM auf einem bereits vorhandenen System.

Die Vorteile liegen auf der Hand und sind in der Praxis gewaltig:

- Enorme Kostenersparnis: Weniger physische Hardware bedeutet direkt weniger Ausgaben für Anschaffung, Strom und Kühlung.

- Flexibilität im Handumdrehen: Neue Systeme sind innerhalb von Minuten startklar, nicht erst nach Tagen oder Wochen. VMs lassen sich bei Bedarf auch kinderleicht kopieren oder auf andere Hardware verschieben.

- Ein Plus an Sicherheit: Anwendungen laufen in gekapselten Umgebungen, sogenannten Sandboxes. Ein Absturz oder ein Sicherheitsproblem in einer VM hat keinerlei Auswirkungen auf den Host oder andere VMs.

- Perfekt für Tests und Entwicklung: Entwickler können neue Software oder kritische Updates in einer sicheren VM-Umgebung auf Herz und Nieren prüfen, ohne das produktive System auch nur anzufassen.

Im Kern schafft eine virtuelle Maschine eine Abstraktion der physischen Hardware – sie erzeugt eine softwarebasierte Kopie eines Computers. Diese Entkopplung von Software und Hardware ist der eigentliche Schlüssel zur Effizienz.

In diesem Guide tauchen wir tiefer in die Welt der VMs ein. Wir schauen uns an, wie die zugrunde liegende Software, der sogenannte Hypervisor, diese Magie überhaupt erst möglich macht, beleuchten konkrete Anwendungsfälle für Unternehmen und zeigen auf, wo die entscheidenden Unterschiede zu neueren Ansätzen wie Containern liegen.

Wie der Hypervisor die Magie der Virtualisierung ermöglicht

Der Begriff „virtuelle Maschine“ klingt erstmal ziemlich technisch, aber das Konzept dahinter ist eigentlich ganz greifbar. Stellen Sie sich den Hypervisor einfach als einen extrem fähigen Projektmanager auf einer großen Baustelle vor. Die physische Hardware Ihres Servers – also CPU, Arbeitsspeicher (RAM) und Festplatten – sind dabei die verfügbaren Baustoffe und das Personal.

Ohne einen solchen Manager würde eine einzige, riesige Baustelle (ein Betriebssystem) alle Ressourcen für sich allein beanspruchen. Hier kommt der Hypervisor ins Spiel: Er agiert als zentrale Schaltstelle. Er teilt das Gesamtprojekt geschickt in mehrere kleinere, voneinander unabhängige Baustellen – die virtuellen Maschinen – auf. Dabei sorgt er penibel dafür, dass jede Baustelle genau die Ressourcen bekommt, die sie braucht. Nicht mehr und nicht weniger.

Im Kern ist der Hypervisor die entscheidende Softwareschicht, die entweder direkt auf der Hardware oder auf einem bestehenden Betriebssystem läuft. Seine Hauptaufgabe? Er nimmt die physischen Ressourcen des Host-Systems und stellt sie den Gast-Betriebssystemen als virtuelle Hardware zur Verfügung. Im Grunde genommen gaukelt er jeder VM vor, sie hätte ihren eigenen, dedizierten Computer.

Die zwei Arten von Hypervisoren

Hypervisor ist nicht gleich Hypervisor. In der Praxis unterscheidet man vor allem zwischen zwei Typen, die für ganz unterschiedliche Szenarien gedacht sind.

Typ-1-Hypervisor (Bare Metal)

Dieser Typ wird direkt auf der „nackten“ Hardware des Servers installiert – er ist sozusagen das Betriebssystem selbst. Weil keine weitere Softwareschicht dazwischenliegt, kann er unfassbar effizient auf die Hardware zugreifen.

- Der große Vorteil: Maximale Leistung und Stabilität, weil der Verwaltungs-Overhead minimal ist.

- Typischer Anwendungsfall: Die absolute erste Wahl für Rechenzentren, Cloud-Anbieter und geschäftskritische Anwendungen.

- Bekannte Beispiele: VMware ESXi, Microsoft Hyper-V oder auch KVM (Kernel-based Virtual Machine).

Typ-2-Hypervisor (Hosted)

Im Gegensatz zum Typ 1 wird dieser Hypervisor wie eine ganz normale Anwendung auf einem bereits installierten Betriebssystem (z. B. Windows, macOS oder Linux) ausgeführt. Perfekt, wenn man mal eben schnell eine Testumgebung auf dem eigenen Laptop braucht.

- Der große Vorteil: Kinderleichte Installation und Handhabung, ideal für Entwickler oder zum Herumprobieren.

- Typischer Anwendungsfall: Softwareentwicklung, das Testen von Programmen auf verschiedenen Betriebssystemen oder einfach für den privaten Gebrauch.

- Bekannte Beispiele: Oracle VirtualBox, VMware Workstation Player oder Parallels Desktop.

Man kann sagen, der Hypervisor ist der unsichtbare Motor, der die gesamte Virtualisierung am Laufen hält. Er schafft die nötige Isolation, Sicherheit und Ressourcenzuweisung, die virtuelle Maschinen so unglaublich flexibel und stark machen. Ohne ihn wäre eine VM nur eine Ansammlung nutzloser Dateien.

Historisch betrachtet ist die virtuelle Maschine ein Konzept, das eng mit der Hardware-Entwicklung der letzten Jahrzehnte verknüpft ist. Die ersten Virtualisierungstechniken kamen zwar schon in den 1960er-Jahren für Großrechner auf, aber in Deutschland setzten sich VMs erst mit dem Aufkommen leistungsfähiger x86-Prozessoren und ihrer Virtualisierungs-Features ab den frühen 2000er-Jahren wirklich durch.

Warum der Hypervisor so entscheidend ist

Die Wahl des richtigen Hypervisors ist eine strategische Entscheidung für jede IT-Infrastruktur. Er legt nicht nur die Leistungsfähigkeit der VMs fest, sondern auch deren Sicherheit und wie gut sie sich verwalten lassen. Ein guter Hypervisor kann CPU-Zyklen und Speicherzugriffe so effizient jonglieren, dass die Leistung einer VM fast an die eines physischen Systems herankommt.

Gleichzeitig sorgt er für eine absolut strikte Kapselung. Wenn eine VM ein Problem hat – sei es ein Systemabsturz oder ein Virus – bleibt dieses Problem auf diese eine VM beschränkt. Es kann nicht auf den Host oder andere VMs überspringen. Genau dieser Mechanismus ist die Grundlage für sichere Umgebungen mit mehreren Mandanten (Multi-Tenant), wie sie im Cloud-Computing heute Standard sind. Mehr zu diesem Grundprinzip erfahren Sie übrigens in unserem Artikel, der erklärt, was Virtualisierung genau ist.

Warum Unternehmen auf virtuelle Maschinen setzen

Die Theorie hinter einer virtuellen Maschine ist zwar spannend, aber im Unternehmensalltag zählen vor allem handfeste, messbare Vorteile. VMs sind weit mehr als nur eine technische Spielerei – sie sind ein strategisches Werkzeug, das die IT-Infrastruktur von Grund auf effizienter, sicherer und flexibler macht. Ihr Einsatz führt direkt zu geringeren Kosten und spürbar optimierten Arbeitsabläufen.

Der wohl größte Hebel, den Unternehmen durch Virtualisierung ansetzen, ist die Serverkonsolidierung. Früher galt oft die einfache Regel: eine Anwendung, ein physischer Server. Das Ergebnis waren riesige, stromhungrige Serverräume, in denen die meisten Maschinen die meiste Zeit über im Leerlauf vor sich hin dümpelten. Eine enorme Verschwendung von Kapital und Ressourcen.

Mit virtuellen Maschinen gehört dieses Szenario der Vergangenheit an. Auf einem einzigen, leistungsstarken physischen Server können heute problemlos mehrere VMs parallel laufen, wobei jede VM als eigenständiger Server für eine bestimmte Anwendung agiert. Das Resultat? Eine drastisch höhere Auslastung der vorhandenen Hardware.

Direkte Kostensenkung durch Konsolidierung

Diese Konsolidierung schlägt sich direkt in den Finanzen nieder. Weniger physische Server bedeuten ganz konkret:

- Geringere Hardwarekosten: Statt zehn Server zu kaufen, reichen vielleicht einer oder zwei.

- Reduzierte Stromkosten: Ein Server verbraucht deutlich weniger Energie als zehn.

- Niedrigere Kühlkosten: Wo weniger Wärme erzeugt wird, muss auch weniger gekühlt werden.

- Weniger Platzbedarf: Der Platz im Rechenzentrum wird effizienter genutzt oder kann sogar reduziert werden.

Statistiken aus der Praxis untermauern diesen Effekt eindrucksvoll. In deutschen Unternehmen laufen im Durchschnitt etwa 6 bis 7 virtuelle Maschinen auf einem physischen Server. Diese Zahlen zeigen deutlich, wie gezielt Virtualisierung zur Effizienzsteigerung im IT-Betrieb eingesetzt wird, wie eine Analyse der Konsolidierungsraten belegt.

Beschleunigte Entwicklung und sichere Testumgebungen

Über die reinen Kosteneinsparungen hinaus verändern VMs die Art und Weise, wie Software entwickelt und getestet wird. Entwicklerteams brauchen ständig saubere, isolierte Umgebungen, um neuen Code zu schreiben oder Updates zu prüfen, ohne das produktive System zu gefährden.

Eine neue VM lässt sich in Minuten erstellen, mit dem exakten Abbild des Live-Systems bespielen und dem Team zur Verfügung stellen. Diese isolierte Sandbox-Umgebung ist perfekt für Tests. Geht etwas schief, wird die VM einfach gelöscht und eine neue aufgesetzt – ohne jegliche Auswirkung auf andere Systeme. Dieser Prozess beschleunigt Entwicklungszyklen erheblich und minimiert das Risiko von Fehlern in der Live-Umgebung.

Eine virtuelle Maschine bietet die perfekte Balance zwischen Isolation und Effizienz. Sie gibt Entwicklern die Freiheit, ohne Risiko zu experimentieren, und Administratoren die Kontrolle, Ressourcen optimal zu verteilen.

Zudem ermöglichen VMs das Betreiben von Legacy-Anwendungen. Viele Unternehmen sind noch immer auf ältere Software angewiesen, die auf modernen Betriebssystemen nicht mehr lauffähig ist. Statt veraltete Hardware mühsam am Leben zu erhalten, kann die Anwendung einfach in einer VM mit dem passenden alten Betriebssystem auf moderner, zuverlässiger Hardware weiterbetrieben werden.

Business Continuity und einfache Disaster Recovery

Ein weiterer entscheidender Vorteil liegt in der verbesserten Ausfallsicherheit. Virtuelle Maschinen sind im Grunde genommen nur große Dateien, und das macht die Datensicherung und Wiederherstellung revolutionär einfach.

Snapshots sind hier ein mächtiges Werkzeug: Mit nur einem Klick lässt sich der komplette Zustand einer VM – inklusive Arbeitsspeicher, Betriebssystem und aller laufenden Anwendungen – einfrieren und speichern. Vor einem kritischen Update wird ein Snapshot erstellt. Schlägt die Aktualisierung fehl, kann die VM in Sekundenschnelle auf den exakten Zustand davor zurückgesetzt werden.

Für die Disaster Recovery ist das ein Gamechanger. Komplette VMs können leicht auf andere physische Server oder sogar in ein anderes Rechenzentrum repliziert werden. Fällt der primäre Standort aus, können die replizierten VMs innerhalb kürzester Zeit am sekundären Standort hochgefahren werden, was Ausfallzeiten drastisch reduziert. Diese Flexibilität ist auch die Basis für moderne Cloud-Infrastrukturen wie IaaS (Infrastructure as a Service), bei denen Rechenleistung bedarfsgerecht bereitgestellt wird.

Vergleich Virtuelle Maschine vs. Physischer Server

Um die Unterschiede auf den Punkt zu bringen, hier ein direkter Vergleich der wichtigsten Merkmale von virtuellen Maschinen gegenüber traditionellen physischen Servern. Die Tabelle macht deutlich, warum die Virtualisierung für moderne IT-Infrastrukturen so attraktiv ist.

| Merkmal | Virtuelle Maschine (VM) | Physischer Server |

|---|---|---|

| Ressourcennutzung | Sehr hoch; mehrere VMs teilen sich eine Hardware | Oft gering; ein Betriebssystem pro Server |

| Bereitstellungszeit | Minuten | Tage oder Wochen |

| Hardwarekosten | Deutlich reduziert durch Konsolidierung | Hoch; für jede Anwendung wird ein Server benötigt |

| Portabilität | Sehr hoch; VMs sind dateibasiert und leicht zu migrieren | Sehr gering; an physische Hardware gebunden |

| Ausfallsicherheit | Hoch durch Snapshots und einfache Replikation | Komplex und teuer in der Umsetzung |

| Isolation | Stark; vollständige Kapselung des Betriebssystems | Physische Trennung |

Wie man sieht, bieten VMs in fast allen relevanten Bereichen erhebliche Vorteile – von der Kosten- und Ressourceneffizienz bis hin zur Flexibilität und Ausfallsicherheit. Sie sind ein fundamentaler Baustein für eine agile und widerstandsfähige IT.

Anwendungsfälle, die Sie im Alltag antreffen

Virtuelle Maschinen bilden oft im Hintergrund das Fundament zahlreicher digitaler Services, die wir tagtäglich nutzen. Ob beim Surfen, Softwaretest oder Datenarchiv: Ohne VMs wäre die moderne IT kaum denkbar.

Im Entwicklungsbereich dienen sie als isolierte Sandbox-Umgebungen, in denen neue Programme ohne Risiko ausprobiert werden können.

- Testsandbox für neue Anwendungen, ohne Produktionsumgebung zu beeinträchtigen

- Webhosting mit automatischer Skalierung je nach Bedarf

- Legacy-Betrieb: Alte Software läuft sicher auf aktueller Hardware weiter

Tests in isolierten Sandboxes

In wenigen Minuten lässt sich eine Sandbox-VM aufsetzen, die sämtliche Testläufe strikt vom Host trennt. So können Entwickler-Teams Updates ausprobieren, ohne dass Produktionsdaten in Gefahr geraten.

- Volle Isolation verhindert Seiteneffekte

- Snapshots erlauben schnelle Wiederherstellung

- Agilere Abläufe dank kurzer Vorbereitungszeiten

Skalierbares Webhosting

Websites lassen sich innerhalb von VMs in Windeseile bereitstellen. Bei plötzlichen Traffic-Spitzen sorgen Cluster und Load Balancer für gleichbleibende Performance.

- Hochverfügbarkeit durch VM-Cluster

- Automatische Lastverteilung bei Besucheransturm

- Ressourcenschonende Konfiguration für mehr Kosteneffizienz

Weiterbetrieb von Legacy-Software

Viele Altanwendungen funktionieren nur noch unter älteren Betriebssystem-Versionen. Mit VMs können Sie diese Programme sicher und performant auf moderner Hardware weiterbetreiben.

| Merkmal | VM-Betrieb | Native Hardware |

|---|---|---|

| Kompatibilität | 100 % dank Emulation | oft eingeschränkt |

| Wartungsaufwand | gering durch zentrale Verwaltung | hoch bei einzelnen Systemen |

| Ausfallsicherheit | hoch durch Snapshots | abhängig von der Hardware |

Hier ein Beispiel aus VirtualBox unter Ubuntu:

Das GUI-Tool zeigt auf einen Blick alle wichtigen Einstellungen. So wird klar, was ist eine virtuelle maschine – und wie einfach sie sich im Alltag nutzen lässt.

Schulungsumgebungen mit VMs

Bildungsanbieter setzen VMs gezielt ein, um Kursteilnehmern praxisnahe Übungsplattformen ohne teure Hardware bereitzustellen.

- Einheitliche Softwarekonfiguration für alle

- Schnelle Rücksetzung auf den Ausgangszustand

- Skalierbarkeit für kleine und große Gruppen

Disaster recovery und business continuity

Wenn ein System ausfällt, starten VMs sekundenschnell an einem Ausweichstandort. Automatisierte Replikation sorgt dafür, dass Dienste weiterlaufen.

- Snapshot-basierte Backups mit minimaler Downtime

- Georedundante VM-Cluster für erhöhte Verfügbarkeit

- Automatisierter Failover per Startskript

„Dank VMs konnten wir unsere Wiederherstellungszeit um 80 % reduzieren und gleichzeitig die Betriebskosten senken“, berichtet ein IT-Leiter aus dem Mittelstand.

Tipps für den produktiven Einsatz

- Monitoring aufsetzen (z. B. mit Prometheus oder Zabbix)

- Ressourcenlimits definieren, um Überprovisionierung zu vermeiden

- Updates und Sicherheits-Patches automatisieren

Ein einfaches CLI-Beispiel für Hyper-V:

New-VM -Name "Ubuntu-Test" -MemoryStartupBytes 2GB -VHDPath "C:VMsUbuntu.vhdx"Start-VM -Name "Ubuntu-Test"

So steht in wenigen Zeilen eine betriebsbereite VM – perfekt für Experimente und Schulungen.

Cloud bursting mit VMs

Bei Lastspitzen greifen Unternehmen auf zusätzliche Cloud-VMs zurück. Das verhindert Engpässe und stellt Dienste stabil bereit.

- Zugriff auf On-Demand-Ressourcen

- Nur bei Bedarf fallen Kosten an

- Nahtlose Integration in die vorhandene Infrastruktur

CI/CD-Pipelines mit VMs

In DevOps-Umgebungen starten VMs automatisiert für Build- und Integrationstests. Nach dem Durchlauf werden sie wieder entfernt.

- Einheitliche Testumgebung für jeden Build

- Vollständige Logs und reproduzierbare Ergebnisse

- Automatische Bereinigung minimiert manuelle Aufwände

Vorteile im IT-Service-Management

Mit virtuellen Maschinen lassen sich Patches zentral verteilen und Inventardaten automatisch sammeln. Das macht den IT-Service effizienter und erhöht die Compliance.

- Zentrales Management via Konsole

- Automatisierte Inventarisierung aller VMs

- Schnelle Rollouts von Sicherheitsupdates

Zusammenfassung anwendungsfälle

Ob Softwaretests, Hosting, Disaster Recovery oder Schulungen – VMs steuern im Unternehmensalltag viele wichtige Prozesse. Ihre Stärken liegen in Flexibilität, Isolation und Automatisierung.

Unternehmen sollten diese Szenarien prüfen und mit Tools wie VirtualBox, VMware oder Cloud-Anbietern wie IONOS eigene VMs erstellen. So erleben sie hautnah den Nutzen von was ist eine virtuelle maschine in der Praxis.

Besuchen Sie Deeken.Technology GmbH für individuelle Beratung zu Ihrer VM-Strategie. Unser Team begleitet Sie bei Planung, Implementierung und Betrieb virtueller Umgebungen. Erfahren Sie mehr auf deeken-group.com und starten Sie Ihre erste VM mit verlässlicher Unterstützung.

Für Unternehmen mit NIS-2-Pflichten bieten VMs zusätzlichen Schutz durch Isolation und schnelle Wiederherstellung. Profitieren Sie von unserer ISO-27001-Zertifizierung und NIS-2-Expertise.

Starten Sie jetzt und sichern Sie Ihre IT nachhaltig mit virtuellen Maschinen.

Unterschied zwischen virtuellen maschinen und containern

Wenn man über virtuelle Maschinen spricht, kommt man an einer anderen modernen Technologie kaum vorbei: Containern. Beide werden oft im selben Atemzug genannt und manchmal sogar verwechselt. Dabei lösen sie ganz ähnliche Herausforderungen auf fundamental unterschiedliche Weise. Wer hier den Unterschied kennt, kann die richtige Technologie für den richtigen Zweck auswählen.

Bleiben wir bei unserer Analogie: Eine virtuelle Maschine ist wie ein komplettes, freistehendes Haus. Es hat ein eigenes Fundament (virtuelle Hardware), massive Wände (ein vollständiges Betriebssystem) und eine individuelle Inneneinrichtung (die Anwendungen und ihre Bibliotheken). Das bietet maximale Sicherheit und Privatsphäre, ist aber im „Bau“ ressourcenintensiv und aufwendig.

Ein Container hingegen ist eher wie ein modernes Apartment in einem großen Wohnkomplex. Alle Apartments teilen sich das Fundament und die Infrastruktur des Gebäudes – in unserem Fall den Kernel des Host-Betriebssystems. Jede Wohnung hat aber ihre eigene Einrichtung (Anwendungen und Bibliotheken) und ist von den Nachbarn klar getrennt. Der Vorteil? Sie sind blitzschnell bezugsfertig und verbrauchen viel weniger „Baumaterial“.

Der kern des unterschieds liegt in der isolationsebene

Der entscheidende technische Unterschied liegt also in der Abstraktionsebene. Eine virtuelle Maschine virtualisiert die gesamte Hardware. Der Hypervisor schafft quasi eine digitale Kopie eines kompletten Computers, auf dem dann ein vollwertiges Gast-Betriebssystem installiert wird. Das sorgt für die extrem starke Isolation, frisst aber auch ordentlich Ressourcen – jedes Gast-OS beansprucht eigene CPU-Zyklen, Arbeitsspeicher und Festplattenplatz.

Container hingegen virtualisieren auf Ebene des Betriebssystems. Sie nutzen den Kernel des Host-Systems gemeinsam und packen nur die Anwendung selbst zusammen mit ihren spezifischen Abhängigkeiten (also Bibliotheken und Konfigurationsdateien) in eine isolierte Umgebung. Dadurch fällt der ganze Ballast eines kompletten Gast-Betriebssystems weg. Das Ergebnis: Container sind extrem leichtgewichtig, starten in Sekundenbruchteilen und nutzen die vorhandene Hardware viel effizienter.

Im Kern geht es um die Frage: Virtualisiere ich die Hardware, um ein Betriebssystem auszuführen (VM), oder virtualisiere ich das Betriebssystem, um eine Anwendung auszuführen (Container)?

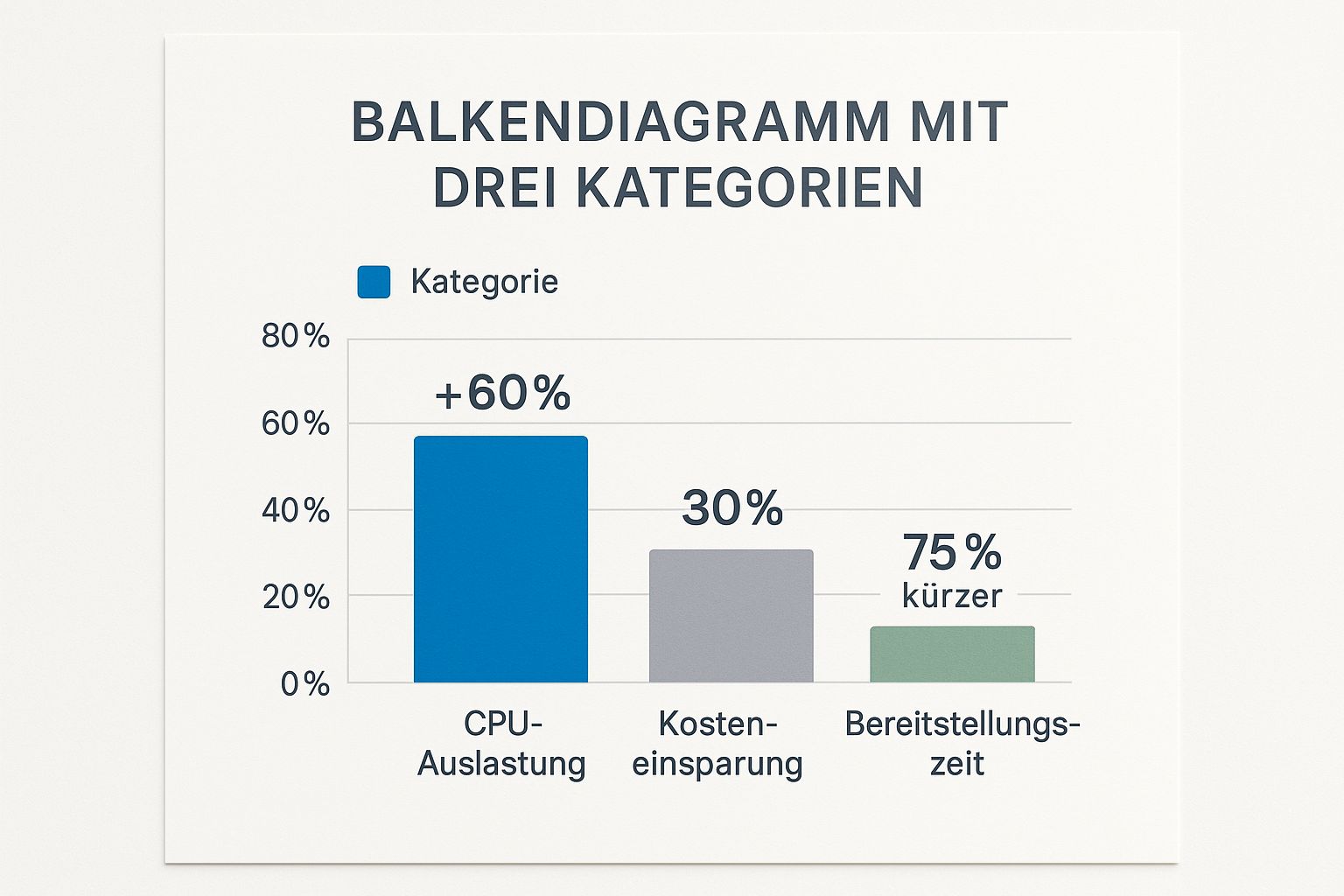

Die folgende Grafik verdeutlicht, wie stark sich der Einsatz von Containern auf wichtige Kennzahlen wie CPU-Auslastung und Bereitstellungszeit auswirken kann.

Die Zahlen sprechen eine klare Sprache: Container können die Bereitstellungszeit um bis zu 75 % verkürzen und gleichzeitig die CPU-Auslastung um über 60 % verbessern. Das schlägt sich direkt in niedrigeren Betriebskosten nieder.

Direkter vergleich: VMs und container im überblick

Um die Unterschiede noch greifbarer zu machen, hilft eine direkte Gegenüberstellung. Die folgende Tabelle fasst die wichtigsten Merkmale zusammen und kann als Entscheidungshilfe dienen.

Unterschiede zwischen VMs und Containern

| Eigenschaft | Virtuelle Maschine (VM) | Container |

|---|---|---|

| Größe | Groß (mehrere Gigabyte), da ein komplettes Betriebssystem enthalten ist. | Klein (oft nur wenige Megabyte), da nur die Anwendung und ihre Abhängigkeiten enthalten sind. |

| Startzeit | Langsam (mehrere Minuten), da ein komplettes Betriebssystem hochgefahren wird. | Sehr schnell (Millisekunden bis Sekunden), da nur der Anwendungsprozess gestartet wird. |

| Isolation | Stark, auf Hardware-Ebene. Jede VM ist vollständig vom Host und anderen VMs getrennt. | Schwächer, auf Prozessebene. Container teilen sich den Kernel des Hosts, was eine potenzielle Angriffsfläche darstellt. |

| Ressourcen | Hoher Verbrauch an CPU, RAM und Speicherplatz durch das Gast-Betriebssystem. | Geringer Verbrauch, da der Host-Kernel und Ressourcen direkt geteilt werden. |

| Portabilität | Mäßig. Eine VM kann migriert werden, ist aber groß und an den Hypervisor gebunden. | Sehr hoch. Ein Container-Image läuft auf jedem System, das eine Container-Engine unterstützt. |

Die Wahl der richtigen Technologie ist also immer eine Abwägung zwischen Isolation, Effizienz und Geschwindigkeit.

Wann sollte man welche technologie einsetzen?

Die Entscheidung für eine VM oder einen Container hängt immer vom konkreten Anwendungsfall ab. Es ist selten ein Entweder-oder, denn oft werden beide Technologien sogar kombiniert, um das Beste aus beiden Welten zu vereinen.

Setzen Sie auf eine virtuelle Maschine, wenn:

- Maximale Sicherheit und Isolation unabdingbar sind, etwa in Multi-Tenant-Umgebungen oder für extrem sicherheitskritische Anwendungen.

- Verschiedene Betriebssysteme auf einem einzigen Host laufen sollen (z. B. eine Windows-Anwendung auf einem Linux-Server).

- Sie eine komplett abgeschottete Umgebung für Legacy-Software benötigen, die auf ein bestimmtes, vielleicht veraltetes Betriebssystem angewiesen ist.

Greifen Sie zu einem Container, wenn:

- Geschwindigkeit und Effizienz im Vordergrund stehen, besonders bei der Entwicklung und Bereitstellung von Anwendungen.

- Sie eine Microservices-Architektur aufbauen, bei der viele kleine, unabhängige Dienste schnell skaliert werden müssen.

- Konsistente Umgebungen für Entwicklung, Test und Produktion (DevOps) entscheidend für Ihren Workflow sind.

Ihre nächsten Schritte in der Virtualisierung

Jetzt wissen Sie also, was eine virtuelle Maschine ist – ein unglaublich vielseitiges Werkzeug, das Flexibilität, Sicherheit und Effizienz in praktisch jede IT-Infrastruktur bringt. Man kann sogar sagen, VMs sind das Fundament, auf dem moderne Cloud-Architekturen überhaupt erst stehen. Aber graue Theorie ist das eine, die Praxis das andere.

Der beste Weg, um die Konzepte dahinter wirklich zu verinnerlichen, ist, selbst die Ärmel hochzukrempeln. Und keine Sorge, dafür müssen Sie nicht gleich in teure Server-Hardware investieren. Kostenlose Tools wie VirtualBox oder der VMware Workstation Player sind perfekt für die ersten Gehversuche auf Ihrem ganz normalen Computer.

Starten Sie Ihre erste eigene VM

Mit ein paar Klicks erschaffen Sie eine komplett isolierte Umgebung, um mal eben ein neues Betriebssystem wie Linux auszuprobieren oder eine unbekannte Software gefahrlos zu testen. Der Prozess ist erstaunlich unkompliziert, und das Erfolgserlebnis, wenn die erste eigene VM hochfährt, motiviert ungemein, tiefer in die Materie einzutauchen.

Hier sind die grundlegenden Schritte, um direkt loszulegen:

- Hypervisor auswählen und installieren: Laden Sie sich eine kostenlose Software wie VirtualBox herunter und installieren Sie sie wie jedes andere Programm auch.

- Betriebssystem-Image besorgen: Sie brauchen eine Installationsdatei (meistens eine .iso-Datei) für das Betriebssystem, das in Ihrer VM laufen soll.

- VM konfigurieren: Weisen Sie Ihrer neuen virtuellen Maschine ein paar Ressourcen zu, etwa Arbeitsspeicher (RAM) und virtuellen Festplattenspeicher.

- Betriebssystem installieren: Starten Sie die VM und folgen Sie den Installationsanweisungen – ganz so, als würden Sie einen echten, physischen Computer einrichten.

Der Sprung von der Theorie zur Praxis ist entscheidend. Die Erstellung Ihrer ersten VM festigt nicht nur Ihr Wissen, sondern eröffnet Ihnen auch ganz neue Möglichkeiten für Tests, Entwicklung und Systemmanagement.

Für fortgeschrittene Anwender, die schon einen Schritt weiterdenken und vielleicht produktive Systeme virtualisieren wollen, ist eine saubere Vorbereitung das A und O. Wenn Sie beispielsweise eine bestehende Windows-Installation auf eine professionelle Virtualisierungsplattform wie Proxmox umziehen möchten, gibt es ein paar spezifische Dinge zu beachten. In unserem Leitfaden zeigen wir Ihnen, wie Sie eine Windows VM für den Umzug auf einen Proxmox Server vorbereiten, damit der Übergang reibungslos klappt.

Nutzen Sie die Gelegenheit und machen Sie Ihre ersten praktischen Erfahrungen. Virtualisierung ist heute eine absolute Kernkompetenz in der IT – und der Einstieg war noch nie so einfach.

Die häufigsten Fragen zur virtuellen Maschine

Nach einer ersten Einführung in die Welt der virtuellen Maschinen tauchen oft ganz konkrete, praktische Fragen auf. Hier geben wir Ihnen die Antworten, die Ihnen helfen, das Thema noch besser zu greifen und letzte Unklarheiten aus dem Weg zu räumen.

Braucht jede VM eine eigene Betriebssystemlizenz?

Ja, das ist in aller Regel so. Man muss sich eine virtuelle Maschine wirklich wie einen eigenständigen, physischen Computer vorstellen. Deshalb benötigt auch jedes Betriebssystem, das Sie darin installieren – egal ob Windows oder eine kommerzielle Linux-Distribution – eine eigene, gültige Lizenz.

Das ist ein nicht zu unterschätzender Kostenfaktor, den Unternehmen bei der Planung ihrer Virtualisierungsstrategie auf dem Schirm haben müssen. Die Lizenzbestimmungen der verschiedenen Softwarehersteller können teils recht komplex sein, ein genauer Blick ins Kleingedruckte ist also unerlässlich.

Wie sicher ist eine virtuelle Maschine eigentlich?

Durch ihre strikte Isolation bietet eine VM von Haus aus ein hohes Maß an Sicherheit. Weil sie komplett vom Host-System und anderen VMs abgeschottet ist, kann ein Problem wie ein Virus oder ein Systemabsturz in einer VM normalerweise nicht auf andere Systeme übergreifen.

Genau diese Eigenschaft macht VMs perfekt für das Testen potenziell unsicherer Software in einer geschützten Sandbox-Umgebung. Man kann experimentieren, ohne den Rest der Infrastruktur zu gefährden.

Man darf aber nicht vergessen: Die VM selbst ist genauso angreifbar wie ein physischer Computer. Sie muss genauso sorgfältig mit Sicherheitsupdates, Firewalls und Antivirensoftware geschützt werden, um sich gegen Angriffe von außen zu wehren.

Macht eine VM meinen Computer langsamer?

Klar ist, der Betrieb einer oder mehrerer VMs kostet zusätzliche Ressourcen. Ihr Host-Computer muss sich CPU-Leistung, Arbeitsspeicher (RAM) und Festplattenzugriffe mit den virtuellen Maschinen teilen. Ob das zu einer spürbaren Verlangsamung führt, ist aber von mehreren Faktoren abhängig.

- Ihre Hardware-Ausstattung: Ein leistungsstarker Rechner mit viel RAM und einer schnellen SSD-Festplatte steckt den Betrieb mehrerer VMs locker weg.

- Die Anzahl der laufenden VMs: Je mehr virtuelle Maschinen gleichzeitig aktiv sind, desto höher ist natürlich die Gesamtlast auf dem System.

- Die Ansprüche der VMs: Eine VM, der Sie viel Arbeitsspeicher und mehrere CPU-Kerne zuweisen, fordert den Host-Rechner logischerweise stärker als eine sparsame Konfiguration.

Moderne Hypervisoren sind aber inzwischen extrem effizient im Umgang mit Ressourcen. Bei einer vernünftigen Hardware-Ausstattung werden Sie im normalen Alltagsbetrieb oft kaum einen Unterschied bemerken.

Kann man eine VM einfach auf einen anderen Computer umziehen?

Ja, und das ist einer der größten Trümpfe der Virtualisierung. Eine virtuelle Maschine ist im Grunde nichts anderes als ein Satz von Dateien, die das komplette System beinhalten – inklusive der virtuellen Festplatte und aller Konfigurationen.

Diese Dateien lassen sich einfach kopieren und auf einen anderen physischen Computer übertragen, auf dem ein passender Hypervisor läuft. Dieser Vorgang, den man auch Migration nennt, sorgt für eine enorme Flexibilität. So kann man Hardware warten oder die Last in einem Rechenzentrum besser verteilen, indem man eine VM einfach auf einen neuen Host startet, wo sie nahtlos weiterläuft.

Möchten Sie das Potenzial der Virtualisierung für Ihr Unternehmen voll ausschöpfen? Die Deeken.Technology GmbH ist Ihr erfahrener Partner für die Planung, Implementierung und den sicheren Betrieb moderner IT-Infrastrukturen. Als ISO-27001-zertifizierter Experte mit NIS-2-Spezialisierung unterstützen wir Sie dabei, Ihre Systeme effizienter, flexibler und sicherer zu gestalten. Erfahren Sie mehr über unsere maßgeschneiderten IT-Lösungen auf https://deeken-group.com.